Аргумент китайской комнаты

Впервые опубликовано 19 марта 2004 года; содержательно переработано 9 апреля 2014 года.

Аргумент и мысленный эксперимент, сегодня известный как аргумент китайской комнаты, впервые был предложен в статье 1980 года американского философа Джона Сёрла (1932-) и стал одним из самых известных аргументов в современной философии. Сёрл представляет следующую картину: он один находится в комнате, где следует инструкциям компьютерной программы, фабрикующей ответы на подсовываемые под дверь таблички с китайскими иероглифами. Сёрл ничего не понимает по-китайски и тем не менее, следуя программе, предписывающей определенные манипуляции с символами и цифрами (так же, как это делает компьютер), он производит правильные строки китайских иероглифов, чем вводит в заблуждение людей, находящийся снаружи (заставляя думать, что в комнате есть кто-то, говорящий по-китайски). Ограниченный вывод из этого аргумента состоит в том, что программирование цифрового компьютера может создать видимость понимания языка, но не создает реального понимания.

Соответственно, «тест Тьюринга» неадекватен. Сёрл утверждает, что мысленный эксперимент подчеркивает следующий факт: компьютеры просто используют синтаксические правила для манипулирования строками символов, но не понимают значения или семантики.

Более широкий вывод из данного аргумента опровергает теорию, которая утверждает, что человеческое сознание является компьютероподобной вычислительной системой или системой обработки информации. Напротив, сознание должно быть результатом биологических процессов; компьютеры же могут в лучшем случае симулировать эти биологические процессы. Таким образом, аргумент имеет большое значение для семантики, философии языка и сознания (mind), теории сознания (consciousness), информатики и когнитивной науки в целом. Как следствие, этот аргумент вызвал множество критических реакций.

Обзор

Исследования в области искусственного интеллекта (ИИ) позволили создать компьютерные программы, способные победить чемпиона мира по шахматам и лучших людей-игроков в телевизионной викторине «Jeopardy». На основе ИИ также были выпущены программы, с которыми можно общаться на естественном языке, в том числе Siri производства Apple. Наш опыт показывает, что игра в шахматы или «Jeopardy», поддержание разговора суть такие действия, которые требуют понимания и интеллекта. Говорит ли способность компьютера участвовать в играх и поддерживать разговор о том, что компьютеры могут понимать и быть разумными?

Приведет ли дальнейшее развитие технологий к появлению таких цифровых компьютеров, которые будут полностью соответствовать человеческому интеллекту или даже превзойдут его? Алан Тьюринг (Turing 1950), один из первых теоретиков вычислительной техники, полагал, что да. Тьюринг предложил то, что сейчас известно под именем «теста Тьюринга»: если компьютер в онлайн-чате будет принят за человека, то мы должны будем признать, что он разумен. К концу 1970-х некоторые исследователи ИИ утверждали, что компьютеры уже понимают по меньшей мере некоторый естественный язык. В 1980 году философ из Калифорнийского университета в Беркли Джон Сёрл представил короткий и широко обсуждаемый аргумент, призванный окончательно доказать, что цифровые компьютеры не могут понимать язык или мыслить.

Сёрл утверждает, что хороший способ проверить теорию сознания, например, теорию, гласящую, что мы можем произвести понимание, сделав то-то и то-то, состоит в том, чтобы представить, каково было бы делать нечто, что, как утверждает данная теория, могло бы создать понимание. Сёрл (Searle 1999) кратко резюмировал аргумент китайской комнаты:

Далее Сёрл утверждает:

Тридцать лет спустя Сёрл описывает свой вывод через понятия осознания (consciousness) и интенциональности (см. статью intentionality):

В прошлом с помощью так называемого аргумента китайской комнаты я показал, что реализация компьютерной программы сама по себе недостаточна для производства сознания или интенциональности (Searle 1980). Вычисления определяются чисто формально или синтаксически, тогда как у сознания есть реальное ментальное или семантическое содержание, и мы не можем перейти от синтаксического к семантическому, имея только синтаксические операции и ничего больше. Выражаясь немного более техническим языком, понятие «та же самая реализованная программа» определяет класс эквивалентности, который устанавливается независимо от какой-либо конкретной физической реализации. Но, установленный таким образом, он неизбежно исключает специфические биологические способности мозга вызывать когнитивные процессы.

Система, например, я, не смогла бы добиться понимания китайского языка простым выполнением шагов компьютерной программы, которая симулировала бы поведение кого-то, кто говорит на китайском языке (2010: 17).

Переход Сёрла от темы машинного понимания к сознанию и интенциональности напрямую не обосновывается первоначальным аргументом 1980 года. Однако то, как он переописывает свой вывод, указывает на то, что его интерпретация значения и интенциональности предполагает наличие тесной связи между пониманием и сознанием. Те, кто не принимает данный подход (т.е. предполагающий связку понимание-сознание), могут полагать, что запуск программы способен создать понимание, не обязательно создавая сознание, а робот может иметь сознание полноценного существа, не обязательно понимая естественный язык.

Таким образом, Сёрл делает более широкие выводы из своего аргумента. Последний направлен на опровержение функционалистского подхода к понимающим сознаниям: согласно функционализму ментальные состояния определяются их каузальной ролью, а не вещами (нейронами, транзисторами), эти роли исполняющими. Этот аргумент особенно важен для одной из версий функционализма, известной как вычислительная теория сознания и рассматривающей сознание как систему обработки информации. Вследствие своего охвата, а также ясного и убедительного стиля изложения аргумент Китайской комнаты, вероятно, стал наиболее широко обсуждаемым философским аргументом в когнитивной науке среди тех, что появились после теста Тьюринга. К 1991 году информатик Пэт Хейс определил когнитивную науку как непрерывный исследовательский проект, опровергающий аргумент Сёрла. Когнитивный психолог Стивен Пинкер (1997) отметил, что к середине 1990-х годов было опубликовано более 100 статей о мыслительном эксперименте Сёрла, и что повсеместность его обсуждений в Интернете послужила для Пинкера убедительной причиной удалиться из всех интернет-форумов.

Интерес к аргументу не угас, а диапазон связей с аргументом китайской расширился. Поиск в Google Scholar по запросу «Searle Chinese Room», ограниченный периодом с 2010 по начало 2014 года, дал более 750 результатов, включая статьи, где прослеживаются связи между самыми разными аргументами и темами — от теории воплощенного познания до театра, разговорной психотерапии, постмодернистских представлений об истине и «нашем постчеловеческом будущем»*, а также обсуждения групповых или коллективных сознаний и обсуждения роли интуиции в философии. Столь широкий спектр дискуссий и обсуждений является данью простоте, ясности и огромной значимости аргумента китайской комнаты.

История вопроса

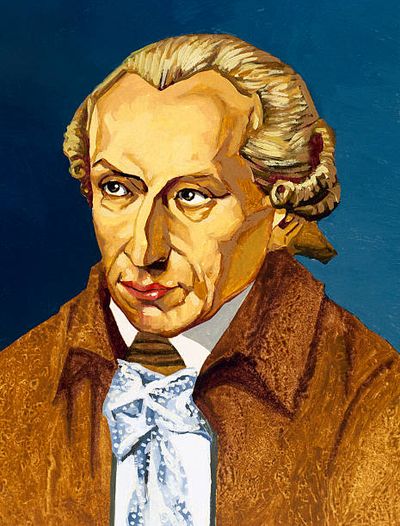

Мельница Лейбница

У аргумента Сёрла есть три важных предшественника. Первый из них — аргумент, изложенный философом и математиком Готфридом Лейбницем (1646–1716). Этот аргумент, часто называемый «Мельницей Лейбница», появляется в 17-ом разделе трактата Монадология. Как и аргумент Сёрла, аргумент Лейбница принимает форму мысленного эксперимента. Лейбниц просит нас представить физическую систему, машину, чье поведение заставляет нас предположить, что она мыслит и имеет опыт («восприятие»):

Обратите внимание, что стратегия Лейбница заключается в противопоставлении внешнего поведения машины, которое может казаться продуктом осознанного мышления, и типа ее внутренней работы. Он указывает, что эти внутренние механические операции — всего лишь элементы, движущиеся от точки к точке, и, следовательно, среди них нет ничего, что обладало бы сознанием или могло бы объяснить мышление, чувство или восприятие. Для Лейбница физические состояния не достаточны для ментальных состояний и не являются для них определяющими.

Бумажная машина Тьюринга

Вторым предшественником аргумента китайской комнаты была идея бумажной машины — компьютера, реализуемого человеком. Данную идею предложил Алан Тьюринг, например, в статье «Машинерия интеллекта» (Intelligent Machinery 1948). Тьюринг пишет, что он написал программу для «бумажной машины» для игры в шахматы. Бумажная машина — это своего рода программа, последовательность простых шагов, наподобие компьютерной программы, но написанная на естественном языке (например, английском) и приводящаяся в действие человеком. Человеку-оператор бумажной шахматной машины не обязательно (при прочих равных) знать, как играть в шахматы. Оператор лишь следует инструкциям, предписывающим те или иные ходы на шахматной доске. Фактически, оператору даже не нужно знать, что он или она играет в шахматы: входные и выходные строки**, такие как «N-QB7», ничего не должны значить для оператора бумажной машины.

Тьюринг верил, что компьютеры вскоре смогут демонстрировать внешние признаки разумного поведения при ответе на заданные на английском вопросы и при ведении беседы. Тьюринг (1950) предложил то, что сейчас известно как тест Тьюринга: если компьютер сможет будет принят за человека в онлайн-чате, его следует считать разумным. К концу 1970-х годов, когда компьютеры стали быстрее и дешевле, некоторые из представителей растущего вокруг ИИ сообщества заявили, что их программы могут понимать английские предложения, используя базу данных справочной информации. Работа одного из них, исследователя Йельского университета Роджера Шэнка (Schank & Abelson, 1977), привлекла внимание Джона Сёрла (коллега Сёрла по Калифорнийскому университету в Беркли, Хьюберт Дрейфус, ранее критиковал заявления исследователей ИИ). Шэнк разработал технику, носящую название «концептуальная репрезентация», которая использовала «скрипты» для репрезентации концептуальных отношений (форма концептуальной семантики ролей). Аргумент Сёрла был первоначально представлен в качестве ответа на утверждение, что программы ИИ, подобные разработанной Шэнком, в буквальном смысле понимают предложения, на которые отвечают.

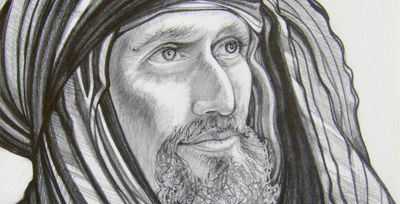

Китайская нация

Третий и более непосредственный предшественник аргумента китайской комнаты возник в ранних дискуссиях вокруг функционалистских теорий разума и познания. Функционалисты считают, что ментальные состояния определяются исполняемой ими каузальной ролью в рамках той или иной системы (точно так же, как дверной стопор определяется тем, что он делает, а не тем, из чего сделан). Критики функционализма быстро обратили провозглашенное достоинство множественной реализуемости*** против нее самой. В отличие от тип-типовых теорий идентичности****, функционализм позволял существам с иной физиологией иметь те же типы психических состояний, что и люди – например, боль. Однако было отмечено, что если инопланетяне могут реализовать функциональные свойства, составляющие ментальные состояния, то, вероятно, то же самое могут делать и системы, еще менее похожие на человеческий мозг. «Вычислительная» версия функционализма особенно уязвима перед этим аргументом, поскольку очень многие системы с простыми компонентами вычислительно эквивалентны друг другу (см., напр., Maudlin 1989, где приводится пример компьютера, построенного из ведер воды). Критики спрашивали, насколько правдоподобно предположение о том, что эти неорганические системы могут иметь ментальные состояния или чувствовать боль.

Даниэл Деннетт (1978) сообщает, что в 1974 году Лоуренс Дэвис провел коллоквиум в Массачусетском технологическом институте (MIT), на котором представил одну из таких неортодоксальных реализаций. Деннет резюмирует мысленный эксперимент Дэвиса следующим образом:

В работе «Проблемы функционализма», также опубликованной в 1978 году, Нед Блок воображает картину, где все население Китая выполняет функции нейронов в мозге. Этот сценарий впоследствии получил название «Китайская нация», или «Китайский тренажерный зал». Мы можем предположить, что каждому гражданину Китая будет предоставлен список телефонных номеров, и в заранее установленное время в день реализации назначенные «входящие» (input) граждане будут запускать процесс, вызванивая тех, кто находится в их списке вызовов. Когда зазвонит телефон любого из граждан, он или она позвонит тем, кто будет в его или ее списке, а те, в свою очередь, свяжутся с другими. По телефону не нужно будет обмениваться сообщениями; все, что требуется, так это паттерн звонков. Списки вызовов должны быть сконструированы таким образом, чтобы паттерны вызовов реализовывали те же паттерны активации, которые возникают между нейронами в чьем-то мозгу, когда этот человек находится в определенном ментальном состоянии, например, испытывает боль. Телефонные звонки играют ту же функциональную роль, что и активирующие друг друга нейроны. Блок интересовался прежде всего квалиа***** и, в частности, вопросом о том, насколько обоснованно было бы предположить, что население Китая коллективно испытывает боль при том, что ни один представитель населения ее не испытывает. Однако его мысленный эксперимент применим к любым ментальным состояниям и операциям, включая понимание языка.

Таким образом, предшествующий мысленный эксперимент Блока, как и построения Дэвиса и Деннетта, предлагает рассмотреть систему из многих людей, а не из одного человека. Основное внимание в них уделяется сознанию, но в той степени, в которой аргумент Сёрла также включает сознание, данный мысленный эксперимент тесно связан с экспериментом Сёрла.

Аргумент китайской комнаты

В 1980 году Джон Сёрл опубликовал статью «Сознание, мозг и программы» (Сёрл 1998) в журнале The Behavioral and Brain Sciences (BBS). В этой статье Сёрл излагает аргумент, а затем отвечает на несколько основных возражений, высказанных во время его предыдущих выступлений в различных университетских кампусах (см. следующий раздел). Кроме того, статья Сёрла в BBS была опубликована вместе с комментариями и критикой 27 исследователей-когнитивистов. После них следовали ответы Сёрла на возражения его критиков.В течение десятилетий после публикации аргумент китайской комнаты был предметом множества дискуссий. К 1984 году Сёрл представил аргумент китайской комнаты в книге «Сознание, мозг и наука» (Сёрл 1993). В январе 1990 года популярное периодическое издание Scientific American организовало дебаты для широкой научной аудитории. Сёрл включил аргумент китайской комнаты в свою статью «Разум мозга — компьютерная программа?» (Сёрл 1990), за которой следовала ответная статья «Может ли машина думать?», написанная философами Полом и Патрицией Черчленд. Вскоре после этого Сёрл опубликовал свою дискуссию об аргументе китайской комнаты с другим ведущим философом, Джерри Фодором (в Rosenthal (ed.) 1991).В центре аргумента китайской комнаты находится человеческая симуляция компьютера, подобная бумажной машине Тьюринга. Человек в китайской комнате следует английским инструкциям, которые предписывают определенные операции с китайскими символами, тогда как компьютер «следует» программе, написанной на компьютерном языке. Человек, следуя инструкциям, производит впечатление владеющего китайским языком, но тем самым нисколько не приближается к понимаю китайского. Поскольку компьютер делает лишь то же самое, что и человек — манипулирует символами исключительно на основе их синтаксиса, — то ни один компьютер, просто следуя программе, не может по-настоящему понимать китайский язык.

Этот ограниченный аргумент, основанный на сценарии «китайской комнаты» (КК), направлен против позиции, которую Сёрл называет «Сильный ИИ». Сильный ИИ — это представление о том, что соответствующим образом запрограммированные компьютеры (или сами программы) могут понимать естественный язык и фактически обладают другими ментальными способностями подобно людям, поведение которых они имитируют. Согласно «Сильному ИИ», эти компьютеры действительно играют в шахматы разумно, делают умные ходы или понимают язык. Напротив, «слабый ИИ» — гораздо более скромное утверждение о том, что компьютеры просто полезны в психологии, лингвистике и других областях: отчасти потому, что они могут симулировать ментальные способности. Но слабый ИИ не утверждает, что компьютеры на самом деле понимают или разумны. Аргумент китайской комнаты не направлен против слабого ИИ, также как и не претендует показать, что ни одна машина не может думать: Сёрл говорит, что мозги — это машины, а мозги думают. Аргумент направлен против мнения, что формальные вычисления на символах могут производить мысль.

Мы могли бы обобщить ограниченный аргумент, представив его в качестве reductio ad absurdum сильного ИИ. Это будет выглядеть так. Пусть L будет естественным языком, а «программа для L» — это программа для свободного общения на L. Вычислительная система — это любая система, человеческая или иная, которая способна запустить программу.

Если сильный ИИ верен, то существует программа для китайского языка — такая, что если какая-либо вычислительная система запускает данную программу, она тем самым начинает понимать китайский язык.

Я мог бы запустить программу для китайского, не понимая при этом китайский.Следовательно, сильный ИИ ложен.

Вторая посылка подкрепляется мысленным экспериментом китайской комнаты. Вывод из этого ограниченного аргумента заключается в том, что запуск программы не может наделить систему пониманием языка. Более широкий аргумент Сёрла включает утверждение о том, что мысленный эксперимент в более общем смысле показывает невозможность получения семантики (значения) из синтаксиса (формальное манипулирование символами). Все это и связанные с этим вопросы обсуждаются в разделе «Более общие философские проблемы».

Ответы на аргумент китайской комнаты

Критика ограниченного аргумента китайской комнаты против Сильного ИИ часто следовала трем основным линиям аргументации. Их можно разделить на три группы исходя из величины уступки, на которую они готовы пойти.

(1) Некоторые критики признают, что находящийся в комнате человек не понимает китайский, но при этом полагают, что запуск программы тем не менее может создать нечто, что понимает китайский. Они оспаривают правомерность вывода, в соответствии с которым из посылки «человек в комнате не понимает китайский» следует заключение «программе не удалось создать понимание». Понимание может присутствовать у большей или же другой сущности. Это стратегия Ответа от Систем (ОС) и Ответа от Виртуального Сознания (ОВС). В них утверждается, что выходящая (output) из комнаты информация свидетельствует о том, что система понимает китайский, но не о том, что оператор понимает китайский. Таким образом, эти критики допускают, что человек в комнате не понимает китайский, но отвергают утверждение Сёрла, что понимание не возникает вообще и что компьютационализм****** ложен.

(2) Другие критики соглашаются с утверждением Сёрла, что простое выполнение программы обработки естественного языка, как оно описано в сценарии КИ, не создает никакого понимания: пониманием не обладает ни человек, ни компьютерная система. Однако они считают, что изменение в компьютерной системе могло бы привести к пониманию. Вариантом такого изменения может быть компьютер, встроенный в роботизированное тело, взаимодействующее с физическим миром через датчики и двигатели («Ответ От Робота»), или это может быть система, которая тщательно имитирует работу всего мозга, нейрон за нейроном («Ответ От Симулятора Мозга»).

(3) Наконец, некоторые критики не уступают даже ограниченному возражению против ИИ. Они считают, что человек в первоначальном сценарии «Китайской комнаты», несмотря на заверения Сёрла в обратном, мог бы понимать китайский, или же что этот сценарий невозможен. К примеру, критики утверждают, что наша интуиция в таких случаях ненадежна. Другие считают, что все зависит от того, что подразумевается под «пониманием». Эти вопросы обсуждаются в разделе «Ответ От интуиции». Другие (напр., Sprevak 2007) возражают против предположения, что любая система (например, Сёрл в комнате) способна запустить любую компьютерную программу. Наконец, некоторые утверждают, что коль скоро было бы неразумно приписывать понимание исходя из поведения китайской комнаты, то его неразумно было бы приписывать и людям на основе аналогичных поведенческих черт (Сёрл называет эту линию аргументации «Ответом От Других Сознаний» (ОДС)). Возражение состоит в том, что мы должны быть готовы приписать понимание китайской комнате на основе наблюдаемого поведения — так же, как мы делаем с другими людьми (и некоторыми животными) и как бы мы поступили с внеземными пришельцами (или горящими кустами, или ангелами), которые говорили бы на нашем языке.

В дополнение к этим ответам, относящимся конкретно к сценарию китайской комнаты и ограниченному аргументу, который будет здесь обсуждаться, некоторые критики также и независимо друг от друга выступают против более общего утверждения Сёрла. Они считают, что семантику (то есть значение) можно получить из синтаксических операций с символами — включая ту операцию, что проделывает цифровой компьютер: этот вопрос обсуждается далее в разделе о синтаксисе и семантике.

Ответ от систем

В оригинальной статье 1980 года Сёрл выделил и обсудил несколько ответов на аргумент, с которыми он столкнулся в различных дискуссиях. В результате эти ранние ответы получили наибольшее внимание в последующих спорах. То, что Сёрл (1980) называет «возможно, самым распространенным ответом», — это «Ответ от систем» (ОС).

Сторонники ОС, который, по словам Сёрла, изначально разрабатывался в Йельском Университете, готовы признать, что человек в комнате не понимает китайский, однако, говорится далее, человек — это всего лишь часть, центральный процессор (ЦП) в более крупной системе. Большая система включает в себя огромную базу данных, содержащую промежуточные состояния памяти (блокноты) и инструкции — полную систему, необходимую для ответа на заданные по-китайски вопросы. Таким образом, ОС заключается в том, что, хотя человек, управляющий программой, не понимает китайский язык, система как целое его понимает.

Нед Блок был одним из первых, кто высказался в пользу ОС, наряду со многими другими, включая Джека Коупленда, Даниэла Деннетта, Джерри Фодора, Джона Хаугеланда, Рэя Курцвейла и Жоржа Рей. Рей (Ray 1986) говорит, что человек в комнате есть только центральный процессор системы. Курцвейл (Kurzweil 2002) говорит, что человек является просто исполнителем и как таковой не важен (вероятно, имеется ввиду, что свойства исполнителя не обязательно являются свойствами системы). Курцвейл руководствуется духом теста Тьюринга и считает, что если система явным образом демонстрирует способность понимать китайский язык, то «она действительно должна понимать китайский язык». Отсюда следует, что Сёрл противоречит самому себе, говоря, что «машина говорит по-китайски, но не понимает по-китайски».

Маргарет Боден (Boden 1988) поднимает дискуссию на более высокий уровень. «Вычислительная психология не приписывает мозгу способность видеть ростки бобов или понимать английский язык: такие интенциональные состояния являются свойствами людей, а не мозга» (244). «Если говорить кратко, то сёрловское описание псевдомозга робота (т.е. Сёрла-в-роботе) как понимающего английского языка содержит категориальную ошибку, сравнимую с трактовкой мозга как носителя разума, противоположного при этом его каузальной основе». Боден указывает, что оператор комнаты — сознательный агент, в то время как процессор в компьютере — нет. В сценарии китайской комнаты нас просят встать на точку зрения исполнителя, а потому неудивительно, что мы не видим общей картины.

Реакция Сёрла на ОС проста: в принципе, человек мог бы интериоризировать всю систему, помня все инструкции и базу данных и производя все вычисления в своей голове. Затем он мог бы выйти из комнаты и побродить по улице, возможно, даже разговаривая по-китайски. Однако он все равно не мог бы придать «какое-либо значение формальным символам». Человек теперь был бы всей системой, но все равно не понимал бы по-китайски. Например, он не знал бы значения китайского слова для гамбургера. Он все еще не мог бы получить семантику из синтаксиса. (cм. далее раздел «Синтаксис и семантика».)

В своей статье «Китайская комната с логической точки зрения» Джек Коупленд (Copeland 2002) рассматривает реакцию Сёрла на ОС и утверждает, что гомункулус в голове Сёрла способен понимать, даже если это не может делать сам оператор комнаты — так же, как модули в нашем сознании решают тензорные уравнения, позволяя нам ловить крикетные шары. Затем Коупленд переходит к рассмотрению сценария «китайского тренажерного зала» и, по-видимому, снова встает на сторону ОС: «… отдельные игроки [не] понимают китайский. Но из этого не следует, что симулятор как целое не понимает китайский язык. Ошибка, возникающая при переходе от части к целому, очевидна здесь еще больше, чем в первоначальной версии аргумента китайской комнаты». Коупленд также отрицает, что коннекционизм подразумевает наличие у комнаты способности имитировать мозг.

Джон Хаугеланд пишет (Haugeland 2002), что реакция Сёрла на ОС ошибочна: «… теперь он спрашивает, что было бы, если бы он в своем разуме сознательно реализовал базовые формальные структуры и операции, которых, согласно теории, достаточно для реализации другого разума». По словам Хаугеланда, его неспособность понять китайский не имеет значения: он всего лишь исполнитель. Понять бы смогла более крупная система реализации — то есть данное рассуждение путает уровни описания.

Шеффер (Shaffer 2009) исследует модальные аспекты логики АКК и утверждает, что близкие версии ОС предвосхищают основание (question-begging). Но, утверждает он, модализированная версия ОС работает успешно, поскольку существуют возможные миры, где понимание является эмерджентным свойством сложной синтаксической манипуляции. Работа Ньюта (Nute 2011) — это ответ Шефферу.

Стеван Харнад в двух своих статьях защищал аргумент Сёрла против критиков, выступавших с позиции ОС. В своей статье 1989 года Харнад пишет: «Сёрл формулирует проблему следующим образом: является ли разум компьютерной программой? Или, более конкретно, если компьютерная программа имитирует или симулирует такую нашу деятельность, которая, по-видимому, требует понимания (например, общение на языке), можно ли сказать, что сама программа, осуществляющая такую деятельность, понимает?» (Обратите внимание на конкретное утверждение: проблема заключается в том, понимает ли сама программа.) Харнад заключает: «На первый взгляд, [аргумент КК] выглядит верным. Это, безусловно, работает против самого распространенного возражения — “ответа от систем”… ». Похоже, Харнад, связывая понимание и состояния сознания, следует за Сёрлом: Харнад (2012) утверждает, что Сёрл показывает, что основная проблема сознательного «чувства» для своего решения требует сенсорных связей с реальным миром.

Ответ от виртуального сознания

В Ответе от виртуального сознания (ОВС), как и в Ответе от систем, признается, что оператор китайской комнаты не приобретает понимание китайского, всего лишь запуская бумажную машину. Однако в ОВС предполагается, что значение имеет отнюдь не это. Важно то, было ли создано понимание, а не то, является ли понимающим агентом именно оператор системы. В отличие от ОС, ОВС гласит, что работающая система может создавать новые виртуальные объекты, отличные как от системы в целом, так и от подсистем, таких как ЦП или оператор. В частности, работающая система может создать отдельного агента, который понимает китайский язык. Этот виртуальный агент будет отличаться как от оператора комнаты, так и от всей системы. Психологические черты, включая языковые способности, любого созданного искусственным интеллектом сознания будут полностью зависеть от программы и базы данных на китайском языке и не будут идентичны психологическим чертам и способностям процессора или оператора бумажной машины (такого, как Сёрл в сценарии китайской комнаты). Согласно ОВС, ошибка аргумента китайской комнаты заключается в том, что в нем предполагается, будто тезис сильного ИИ состоит в том, что «компьютер понимает китайский» или что «система понимает китайский». Ключевым вопросом для ИИ должен быть всего лишь вопрос о том, «создает ли работающий компьютер понимание китайского».

Знакомая многим модель виртуальных агентов — это персонажи компьютерных или видеоигр, а также персональные цифровые помощники, такие как Siri от Apple и Cortana от Microsoft. Эти персонажи обладают различными способностями и характерами и не идентичны системному оборудованию или программе, которая их создает. Одна работающая система может одновременно управлять двумя разными агентами или физическими роботами, один из которых говорит только на китайском, а другой — только на английском (или, иначе, обладают совершенно разными личностями, воспоминаниями и когнитивными способностями). Таким образом, ответ ВС предлагает провести различие между сознаниями и системами, которые их «реализуют».

Мински (Minsky 1980), Сломан и Кроучер (Sloman and Croucher 1980) предложили ответ ВС сразу же после появления аргумента китайской комнаты. В своей широко известной статье 1989 года «Вычисление и сознание» Тим Модлин рассматривает минимальные физические системы, которые могут реализовывать вычислительную систему, запускающую программу. Его рассуждение вращается вокруг воображаемой машины Олимпия — системы ведер, которая передает воду, реализуя тем самым машину Тьюринга.

Основная мишень Модлина — компьютационалистское утверждение о том, что такая машина может иметь феноменальное сознание. Однако в ходе своего рассуждения Модлин обращается к аргументу китайской комнаты. Модлин (цитируя Мински, Сломана и Краучера) указывает на ОВС, утверждая, что понимающий агент может отличаться от физической системы (414). Таким образом, «Сёрл не сделал ничего, что ниспровергло бы возможность одновременного существования непересекающихся ментальностей» (414–5).

Перлис (Perlis 1992), Чалмерс (1996) и Блок (Block 2002) также открыто поддержали те или иные разновидности ответа ВС, как это сделал и Ричард Хэнли в книге «Метафизика Звездного Пути» (1997). Пенроуз (2002) критикует эту стратегию, а Стеван Харнад пренебрежительно отвергает подобные высокопарные обращения к метафизике. Харнад защищал позицию Сёрла в «Виртуальном симпозиуме по виртуальному сознанию» (1992), выступая против Патрика Хейса и Дона Перлиса. Перлис выдвинул аргумент ВС, который, по его словам, выводится из позиции Модлина. Чалмерс (1996) отмечает, что оператор комнаты — это просто каузальный посредник, «демон», поэтому его состояния сознания не имеют отношения к свойствам системы как целого. Как и Модлин, Чалмерс поднимает вопросы личной идентичности: мы можем рассматривать Китайскую комнату как «две ментальные системы, реализованные в одном физическом пространстве. Организация, которая порождает опыт китайского языка, совершенно отличается от организации, которая порождает опыт демона [= оператора комнаты]» (326).

Коул (Cole 1991, 1994) разрабатывает ответ, в котором утверждает следующее: аргумент Сёрла требует, чтобы агентом понимания был сам компьютер или, помимо китайской комнаты, человек в комнате. Однако неспособность Сёрла понимать китайский язык в комнате не говорит о том, что понимание так и не было создано. Если мы расширим диалог в первоначальном сценарии КК, включив в него такие вопросы на китайском языке, как «Какой у тебя рост?», «Где ты живешь?», «Что ты ел на завтрак?», «Как ты относишься к Мао?» и т.д., сразу станет ясно, что ответы на китайском не являются ответами Сёрла. А поскольку Сёрл не является автором ответов, его убеждения и желания, воспоминания и черты личности никак не отражаются в них – в отличие от его усердности! – и не выполняют каузальную роль в производстве ответов на китайские вопросы. Следовательно, если при запуске программы было создано понимание китайского языка, то сознанием, понимающим китайский, будет не компьютер, также как оператор комнаты (в сценарии КК) не будет той личностью, которая понимает китайский. Личность, понимающая китайский, будет отлична от оператора комнаты, а ее верования и желания будут предоставлены программой и соответствующей базой данных. Таким образом, неспособность Сёрла понимать китайский язык во время работы в комнате не показывает, что понимание не создается.

Коул (Cole 1991) предлагает дополнительный аргумент в поддержку утверждения, что понимающее сознание не является ни сознанием оператора комнаты, ни сознанием системы, состоящей из оператора и программы: запуск надлежащим образом структурированной компьютерной программы может произвести ответы китайском языке, а также ответы на корейском. И все же ответы на китайском могут демонстрировать, по-видимому, совершенно иные знания и воспоминания, убеждения и желания, чем ответы на вопросы на корейском, — равно как и отрицание того, что отвечающий на китайском знает корейский, и наоборот. Таким образом, поведенческие черты программы будут свидетельствовать о наличии двух не идентичных друг другу сознаний (одно понимает только китайский, а другое — только корейский). Так как они могут иметь взаимоисключающие психологические свойства, они не могут быть идентичны друг другу и ipso facto не могут быть идентичны с сознанием находящегося в комнате агента. Аналогично, в видеоигре может иметься персонаж с одним набором когнитивных способностей (умный, понимающий по-китайски), а также другой персонаж с набором черт, несовместимых с чертами первого (глупый, английский моноглот). Эти противоречивые когнитивные свойства не могут быть свойствами системы XBOX, которая их реализует. Выводимое отсюда предположение будет состоять в том, что сознания, как правило, более абстрактны, чем реализующие их системы (см. «Сознание и тело» в разделе «Более общие философские проблемы»).

Вкратце, аргумент ВС заключается в следующем: поскольку сёрловское доказательство того, что понимание китайского языка не создается, состояло в том, что он не понимал бы китайский язык в комнате, аргумент КК не может опровергнуть иначе сформулированное утверждение сильного ИИ (настаивающее на возможности достижения понимания с помощью запрограммированного цифрового компьютера). По словам Модлина (Maudlin 1989), Сёрл не предложил убедительного ответа на это возражение.

Другие мыслители, однако, сумели ответить на аргумент ВС, например, Стиван Харнад и специалист по математической физике Роджер Пенроуз. Пенроуз в целом с пониманием относится к темам, которые поднимает Сёрл в связи с аргументом китайской комнаты, и выступает против ответа ВС. Пенроуз не верит, что вычислительные процессы могут объяснять сознание — как ввиду аргумента китайской комнаты, так и ввиду ограничений формальных систем, выявленных Куртом Гёделем в доказательстве неполноты. (У Пенроуза есть две книги об уме (mind) и сознании (consciousness); Чалмерс и другие авторы ответили на его обращения к Гёделю.) В своей статье 2002 года «Сознание, вычисления и китайская комната», где адресно рассматривается аргумент китайской комнаты, Пенроуз утверждает: китайский спортзал (вариация сценария, где комната расширяется до размеров Индии, в которой всю обработку данных осуществляют индийцы) демонстрирует крайнюю неправдоподобность утверждения о наличии «какого-то бестелесного “понимания”, связанного с выполнением этого алгоритма человеком, и чье присутствие при том никак не влияет на его собственное сознание» (230– 1). Пенроуз заключает, что аргумент китайской комнаты опровергает Сильный ИИ. Кристиан Кернбах (Kaernbach 2005) сообщает, что он подверг теорию виртуального сознания эмпирической проверке и получил отрицательный результат.

Ответ от робота

Ответ от робота (ОР) признает правоту Сёрла в отношении сценария Китайской комнаты: последний показывает, что запертый в комнате компьютер не может понимать язык или знать значения слов. ОР чувствителен к проблеме знания значения китайского слова для гамбургера. Последнее, в свою очередь, является для Сёрла примером того, что оператор комнаты не знает. Представляется разумным утверждение, что мы знаем, что такое гамбургер, поскольку видели один и, возможно, даже приготовили, или попробовали, или, по крайней мере, слышали, как люди говорят о гамбургерах, и поняли, что они такое, связав с вещами, которые знаем благодаря видению, приготовлению и поеданию. Учитывая то, каким образом мы можем понять, чем является гамбургер, ОР предполагает нам поместить цифровой компьютер в корпус робота с датчиками (такими как видеокамеры и микрофоны) и добавить управляющие элементы (вроде колес для перемещения и рук, с помощью которых можно манипулировать вещами в мире). Такой робот — компьютер с телом — мог бы делать то, что делает ребенок, то есть учиться посредством наблюдения и деятельности. ОР гласит, что этот цифровой компьютер в теле робота, выпусти мы его из комнаты, мог бы придавать значения символам и действительно понимать естественный язык. Маргарет Боден, Тим Крэйн, Даниэл Деннетт, Джерри Фодор, Стеван Харнад, Ханс Моравек и Джордж были в числе тех, кто поддержал версию данного этого ответа в тот или иной момент. ОР по сути апеллирует к «широкому содержанию» или «внешней семантике». Таким образом, сторонники ОР могут согласиться с Сёрлом в том, что синтаксис и внутренние связи недостаточны для семантики, но в то же время утверждать, что подходящие каузальные связи с миром могут поставлять содержание для внутренних символов.

Сёрл не считает, что данный ответ на аргумент китайской комнаты сильнее ОС. Датчики всего лишь обеспечивают дополнительный ввод в компьютер, а это по-прежнему будет просто синтаксическим вводом. Мы можем в этом убедиться, если внесем параллельное изменение в сценарий китайской комнаты. Предположим, что человек в китайской комнате помимо проскальзывавших под дверь китайских иероглифов получает еще и поток двоичных единиц информации, которые появляются, к примеру, на бегущей строке в углу комнаты. В книге инструкций в качестве вводных данных добавлены схемы использования цифр из строки наряду с китайскими иероглифами. Человек не знает о том, что символы на такой строке представляют собой оцифрованный вывод видеокамеры (и, возможно, других датчиков). Сёрл утверждает, что дополнительные синтаксические вводы не сделают ничего, что позволило бы человеку связать значения с китайскими иероглифами. Это просто прибавит ему работы.

Джерри Фодор, Хилари Патнэм и Дэвид Льюис были главными архитекторами вычислительной теории сознания, попадающей под огонь более широкого аргумента Сёрла. В своем первоначальном ответе на статью Сёрла 1980 года Фодор допускает, что Сёрл определенно прав в том, что «инстанцирования такой же программы, которую инстанцирует мозг, самого по себе недостаточно для приобретения тех же пропозициональных установок, что характерны для организма, обладающего мозгом». Однако Фодор считает, что Сёрл не прав относительно ОР. Компьютер может иметь пропозициональные установки, если он находится в правильных каузальных связях с миром, но они не опосредованы сидящим в голове робота человеком. Мы не знаем, каковы правильные каузальные связи. Но Сёрл допускает ошибку, выводя из тезиса «маленький человек не является правильной каузальной связью» заключение, что никакая каузальная связь не будет успешной. Существует достаточно эмпирических доказательств того, что ментальные процессы включают в себя «манипулирование символами». Сёрл же не предлагает никакого альтернативного объяснения (это иногда называют аргументом Фодора «Единственного варианта» (Only Game in Town) для вычислительных подходов). С тех пор Фодор много писал о том, каковы должны быть связи между состоянием мозга и миром для того, чтобы состояние обладало интенциональными (репрезентативными) свойствами, подчеркивая в последнее время пределы вычислительного подхода, поскольку вычисления по своей природе локальны и, следовательно, не могут объяснить абдукцию*******.

В своей более поздней статье «Инь и Ян в китайской комнате» (в Rosenthal 1991: 524–525) Фодор основательно пересматривает свою точку зрения 1980 года. Он дистанцируется от своей более ранней версии ОР и, вместо этого, утверждает, что «инстанцирование» следует определять так, чтобы символ оказался непосредственной причиной следствия — никаких мешающих парней в комнате не должно быть. Таким образом, Сёрл в комнате — не инстанцирование машины Тьюринга, и «мастер установки (setup) Сёрла не инстанцирует машину, которую инстанцирует мозг». Он приходит к выводу, что: «…мастер установки Сёрла не имеет отношения к утверждению, что сильное тождество мозгу говорящего по-китайски ipso facto достаточно для того, чтобы говорить по-китайски». Сёрл говорит об этом шаге Фодора так: «Из всего несметного количества критических отзывов на аргумент китайской комнаты вариант Фодора, пожалуй, является самым беспомощным. Он утверждает, что именно потому, что человек в китайской комнате намеревается выполнить шаги компьютерной программы, он не выполняет шаги компьютерной программы. Он не предлагает никаких аргументов в пользу этого невероятного утверждения» (в Rosenthal 1991: 525).

В статье 1986 года Джорж Рей отстаивал комбинацию Ответа от систем и Ответа от робота; он отмечал, что оригинального теста Тьюринга недостаточно для проверки разумности и понимания, а также идею о том, что изолированная система, которую Сёрл описывает в комнате, точно не является функционально эквивалентной настоящему носителю китайского языка, ощущающему мир и действующему в нем. Во втором, предпринятом в 2002 году, разборе аргумента КК под названием «Непонимание Сёрлом функционализма и сильного ИИ» Рей снова защищает функционализм от Сёрла, в особенности ту его форму, которую Рей называет «вычислительно-репрезентативной теорией мышления – ВРТМ». ВРТМ не стремится приписать мышление любой системе просто потому, что та проходит тест Тьюринга (например, китайской комнате). Точно также ВРТМ не привязана к той интерпретации понимания естественного языка, которая в берет за образец иностранный разговорник. Скорее, в фокусе внимания ВРТМ находится интенциональность, как естественная, так и искусственная (репрезентации в системе можно подвергнуть семантической оценке: они истинны или ложны и, следовательно, имеют свойство «быть о чем-либо» (aboutness)). Сёрл приписывает функционализму свойственную бихевиоризму черту представлять внутренние процессы как «черные ящики», однако функционализм также интересует то, как они проходят. Рей делает набросок «скромного сознания» — системы ВРТМ, которая обладает восприятием, способна делать дедуктивные и индуктивные выводы, принимать решения исходя из целей и представлений о свойствах мира, а также способна обрабатывать естественный язык путем преобразования в / из его исходных репрезентаций. Для объяснения поведения подобной системы нам понадобятся те же приписывания, которые необходимы для объяснения поведения обычного носителя китайского языка.

Тим Крэйн обсуждает аргумент китайской комнаты в своей книге 1991 года Механический разум. Он приводит аналогию светящейся комнаты, предложенную четой Черчлендов, но затем утверждает, что за то время, когда Сёрл был оператором комнаты, он узнал бы китайский язык: «… если бы Сёрл не только запомнил правила и данные, но и начал действовать в мире китайцев, вполне вероятно, что он вскоре понял бы, что означают эти символы» (127). (Рапапорт (Rapaport 2006) проводит аналогию между Хелен Келлер******** и китайской комнатой.) Похоже, что Крейн в конце приходит к версии ОР: «Аргумент Сёрла сам предвосхищает основание (begs the question), когда (по сути) отрицает центральный тезис ИИ о том, что мышление является формальной манипуляцией символами. Однако, несмотря на это, допущение Сёрла кажется мне правильным ... правильный ответ на аргумент Сёрла был бы таков: конечно, Сёрл в комнате или комната сама по себе не могут понять китайский язык. Но если вы позволите внешнему миру оказать некоторое влияние на комнату, смысл или “семантика”, вероятно, начнут обретать точку опоры. Но, безусловно, этот шаг подразумевает признание того, что мышление не может быть просто манипулированием символами» (129).

Маргарет Боден (Boden 1988) также утверждает: Сёрл ошибается, полагая, что программы представляют собой чистый синтаксис. Однако программы активизируют определенные машины: «Присущие любой компьютерной программе процедурные последствия дают ей точку опоры в семантике, где рассматриваемая семантика является не денотационной, а каузальной» (250). Таким образом, робот может обладать каузальной силой, которая позволила бы ему осуществлять референцию к гамбургеру.

Стиван Харнад также считает важными наши сенсорные и двигательные способности: «Кто мог бы сказать, что тест Тьюринга, будь то на китайском или на любом другом языке, может быть успешно пройден без операций, основанных на наших сенсорных, моторных и других более высоких когнитивных способностях? С чего начинается способность понимать китайский язык и где заканчиваются все наши прочие ментальные способности?». Харнад считает, что символические функции должны основываться на «роботоподобных» функциях, связывающих систему с миром. Он также полагает, что это идет вразрез с символическими интерпретациями ментального (какие предлагает Джерри Фодор) и, как можно предположить, с подходом Роджера Шэнка, который был исходной мишенью аргумента Сёрла. Харнад (Harnad 2012) утверждает, что аргумент КИ показывает, что даже роботу с символами из внешнего мира, все еще чего-то не хватает — не хватает чувства, такого как чувство понимания.

Ответ от симулятора мозга

Рассмотрим компьютер, который работает иначе, чем обычная программа ИИ с ее скриптами и операциями над строками символов, подобными предложениям. В Ответе от симулятора мозга (ОСМ) нас просят предположить, что программа имитирует реальную последовательность нервных импульсов, возникающих в мозгу носителя китайского языка в тот момент, когда этот человек понимает китайский – каждый нерв, каждую вспышку. Поскольку компьютер работает точно так же, как мозг носителя китайского языка, то, обрабатывая информацию таким же образом, он поймет китайский. Ответ, предложенный Полом и Патрицией Черчленд, следует в том же направлении, которое обсуждается далее.

В ответ на это возражение Сёрл утверждает, что это (т.е. способность компьютера имитировать последовательность нервных импульсов в мозгу человека, понимающего язык) не имеет значения. Он предлагает вариант сценария симулятора мозга: предположим, что в комнате у человека есть огромный набор клапанов и водопроводных труб, организованных в том же порядке, что и нейроны в мозгу человека, говорящего по-китайски. Теперь программа сообщает человеку, какие клапаны открывать в ответ на ввод. Сёрл утверждает: ясно, что в описываемой ситуации не было бы понимания китайского языка. (Тем не менее обратите внимание: данное утверждение больше не основывается на том, что сам Сёрл не будет понимать китайский язык. Кажется очевидным, что теперь он просто играет вспомогательную роль в каузальных операциях системы, и, соответственно, мы полагаемся на нашу лейбницианскую интуицию, что водопроводные сооружения не обладают пониманием (см. также Maudlin 1989).) Сёрл приходит к выводу, что симуляция мозговой активности не является чем-то реальным.

Однако, следуя Пилишину (Pylyshyn 1980), Коулу и Фолберу (Cole and Foelber 1984), Чалмерсу (1996), мы могли бы задаться вопросом о гибридных системах. Пилишин пишет:

Эти мысленные эксперименты по киборгизации могут иметь значение также и для китайской комнаты. Предположим, у Отто есть заболевание нервной системы, которое приводит к выходу из строя одного из нейронов в его мозгу, но хирурги устанавливают рядом с его неработающим нейроном крошечный дистанционно управляемый искусственный нейрон — синрон. Этот нейрон контролирует находящийся в китайской комнате Джон Сёрл, причем без ведома их обоих. Крошечные провода соединяют искусственный нейрон с синапсами на клеточном теле поврежденного нейрона. Когда его искусственный нейрон стимулируется нейронами, которые соединяются посредством синапса с его поврежденным нейроном, в китайской комнате загорается свет. Затем Сёрл совершает манипуляции с некоторыми клапанами и переключателями в соответствии с командами программы. Посредством радиосвязи эти манипуляции заставляют искусственный нейрон Отто высвобождать нейротрансмиттеры из их крошечных искусственных пузырьков. Если запрограммированные действия Сёрла заставляют искусственный нейрон Отто вести себя так же, как когда-то вел себя его естественный нейрон, тогда поведение остальной части его нервной системы останется неизменным. Увы, болезнь Отто прогрессирует; все больше нейронов заменяется синронами, контролируемыми Сёрлом. Согласно данной гипотезе остальной мир не заметит разницы. Заметит ли ее Отто?

Под рубрикой «Комбинированный ответ» Сёрл также рассматривает систему с характеристиками всех трех предыдущих ответов — робота с цифровым компьютером, имитирующим мозг в черепной коробке таким образом, что система как целое в результате ведет себя неотличимо от человека. Поскольку нормальный ввод в мозг поступает от органов чувств, естественно предположить, что большинство сторонников ОСМ подразумевают такую комбинацию, как Симулятор Мозга, Робот и ОС. Некоторые (напр., Rey 1986) утверждают, что было бы вполне обоснованно приписать интенциональность такой системе как целому. Сёрл соглашается, что приписать такой системе-андроиду понимание было бы разумно, но только до тех пор, пока вы не знаете, как она работает. Как только вы узнаете правду — о том, что это компьютер, слепо манипулирующий символами на основе синтаксиса, а не значения, — вы бы перестали приписывать ему интенциональность.

(Можно предположить, что это было бы верно даже в случае, если бы это был ваш супруг, с которым вас связывает долгая совместная жизнь, «кремневую тайную» которого вы бы разоблачили. Некоторые научно-фантастические истории, включая эпизоды телесериала Рода Серлинга «Сумеречная зона», основываются на возможности такого сценария; Стивен Пинкер (Pinker 1997) упоминает один эпизод, где секрет андроида был известен с самого начала, но главный герой все же завязал с андроидом романтические отношения.)

В свой десятый юбилей аргумент китайской комнаты был представлен в популярном научном журнале Scientific American. Оппозицию аргумента Сёрла в этом выпуске возглавили философы Пол и Патриция Черчленд. Черчленды соглашаются с Сёрлом, что Китайская комната не понимает китайский, но считают, что сам аргумент пользуется нашим незнанием когнитивных и семантических феноменов. Они приводят параллельный пример «Светящейся комнаты», в которой некто машет магнитом и утверждает, что отсутствие видимого света доказывает ошибочность электромагнитной теории Максвелла. Черчленды отстаивают представление о мозге как о коннекционистской системе, векторном преобразователе, а не о системе, управляющей символами в соответствии со структурно-чувствительными правилами. Система в китайской комнате использует неправильные вычислительные стратегии. Таким образом, они согласны с Сёрлом относительно традиционного ИИ, но, похоже, одобрили бы то, что Сёрл называет «ответом симулятора мозга», утверждая: как и в примере светящейся комнаты, наша интуиция терпит неудачу, когда дело доходит до такой сложной системы, и было бы ошибочно двигаться от части к целому: «… ни один нейрон в моем мозгу не понимает по-английски, хотя мой мозг в целом его понимает».

В своей книге 1991 года «Микропознание» Энди Кларк утверждает, что Сёрл прав в том, компьютер под управлением программы Шэнка ничего не знает о ресторанах, «по крайней мере, если под “знать” мы имеем в виду что-то вроде “понимать”». Однако Сёрл полагает, что его аргумент применим к любой вычислительной модели, в то время как Кларк, подобно Черчлендам, считает, что Сёрл ошибается относительно коннекционистских моделей. Таким образом, Кларк склоняется к ОСМ. Мозг мыслит в силу своих физических свойств. Какие физические свойства мозга важны? Кларк отвечает, что в мозге важны «изменчивые и гибкие подструктуры», которых нет в стандартных системах искусственного интеллекта. Но это не означает, что компьютационализм или функционализм ложны. Все зависит от того, на каком уровне вы выбираете функциональные единицы. Кларк защищает «микрофункционализм»: искать следует детализированное функциональное описание, например, уровень нейронной сети. Кларк с одобрением цитирует Уильяма Ликана в противовес возражению об «отсутствующих квалиа» Блока: да, отсутствующие квалиа возможны, если функциональные единицы сделать большими. Однако это не опровергает функционализм в целом. Соответственно, взгляды Кларка не отличаются от взглядов Черчлендов: он согласен с тем, что Сёрл прав относительно Шэнка и систем обработки на уровне символов, но полагает, что он тот ошибается относительно коннекционистских систем.

Рэй Курцвейл (Kurzweil 2002) также утверждает, что аргумент Сёрла можно исправить, показав, что человеческий мозг не способен понимать: мозг достигает результата, манипулируя концентрациями нейротрансмиттеров и другими механизмами, которые сами по себе бессмысленны. Критикуя реакцию Сёрла на ОСМ, Курцвейл говорит: «Так что, если мы увеличим китайскую комнату Сёрла, сделав ее настолько большой “комнатой”, насколько требуется, кто скажет, что вся система из ста триллионов людей (моделирующих китайский мозг, знающий китайский язык) не является сознательной? Конечно, было бы правильно говорить, что такая система знает китайский язык. И мы не можем сказать, что она более не обладает сознанием — не в меньшей степени, чем мы могли бы сказать это о любом другом процессе. Мы не можем знать субъективный опыт другого существа…»

Ответ от других сознаний

С предыдущим ответом связан Ответом от других сознаний (ОДС): «Откуда вы знаете, что другие люди понимают китайский или какой бы то ни было другой язык? Только благодаря их поведению. Сегодня компьютер может пройти поведенческие тесты так же хорошо, как и они (в общем и целом), поэтому, если вы собираетесь приписывать познание другим людям, вы должны, следуя данному принципу, также приписывать его компьютерам»

Ответ Сёрла (1980) на это был очень краток:

Критики полагают, что если наши доказательства наличия понимания у людей совпадают с возможными доказательствами наличия понимания у внеземных пришельцев, а также — у роботов, то предположения, которые мы можем сделать в отношении нашего собственного вида, нерелевантны, поскольку предпосылки иногда бывают ложными. По тем же причинам Тьюринг, предлагая свой тест, был особенно обеспокоен нашими предпосылками и нашим шовинизмом. Если основания наших предположений относительно человеческих существ прагматичны в том смысле, что они позволяют нам предсказывать поведение людей и эффективно с ними взаимодействовать, то, возможно, такое предположение могло бы применяться точно также и к компьютерам (аналогичные соображения мы встречаем в рассуждениях Деннетта о том, что он называет Интенциональной Установкой).

Сёрл поднимает вопрос о том, что именно мы приписываем, когда приписываем понимание другим сознаниям, утверждая, что сознание есть нечто большее, чем сложные поведенческие навыки. Похоже, для Сёрла определенные состояния сознания являются дополнительными, как видно из его краткого обзора выводов аргумента КК за 2010 год. Терри Хорган (Horgan 2013) поддерживает это утверждение: «истинный смысл мысленного эксперимента китайской комнаты Сёрла заключается в том, что подлинная первичная интенциональность требует присутствия внутренних состояний с присущими им феноменальными свойствами, которые по своей природе интенциональны...» Но эта связь понимания с феноменальным сознанием вызывает множество вопросов.

Мы приписываем ограниченное понимание языка младенцам, собакам и другим животным, но не ясно, что мы ipso facto приписываем им невидимые состояния субъективного сознания. Ведь что мы знаем о скрытых состояниях экзотических существ? Людвиг Витгенштейн (аргумент индивидуального языка) и его последователи выдвинул аналогичные возражения. Возникают возможности измененных квалиа, аналогичные инвертированному спектру: предположим, я спрашиваю «чему равна сумма 5 и 7», а вы отвечаете «сумма 5 и 7 равна 12», но когда вы услышали мой вопрос, у вас был сознательный опыт слышания и понимания «чему равна сумма 10 и 14», хотя при этом находились в «вычислительных состояниях», подходящих для получения правильной суммы, а потому сказали «12». Существуют ли определенные сознательные состояния, которые являются «правильными» для определенных функциональных состояний? Лежащая здесь в основе проблема эпифеноменальности знакома нам по проблемам инвертированного спектра — трудно понять, что добавляет субъективное сознание, если оно само по себе не является функционально важным.

После 30 лет, прошедших после обнародования аргумента КИ, философы заинтересовались зомби — существами, которые выглядят и ведут себя так же, как нормальные люди, включая языковое поведение, но не имеют субъективного сознания. Трудности с утверждением, что субъективные состояния сознания играют ключевую роль в понимании значения, возникнет в подобных случаях отсутствия квалиа: мы не можем отличить зомби от не-зомби, а потому в случае Сёрла мы не можем провести различие между теми, кто действительно понимает английский, и теми, кто его не понимает. Но тогда, похоже, существует отличие, которое не предполагает различия (distinction without a difference). В любом случае, короткий ответ Сёрла на ОДС может быть чересчур коротким.

Как известно, Декарт утверждал, что способности к речи достаточно для приписывания разума и сознания другим существам, а также (что снискало ему дурную славу), что наличие данной способности необходимо для их приписывания. Тьюринг фактически поддерживал условие достаточности Декарта, по крайней мере, для интеллекта, заменив устное языковое поведение на письменное. Поскольку большинство на практике считают способность вести диалог достаточным условием для приписывания понимания, сёрловскому аргументу — который гласит, что речь является достаточным условием для человека (во всех состояниях лунатизма, инсульта?), но не для существ, имеющих отличную от нашей биологию, — в этом случае может возникнуть потребность объяснить, что именно приписывается дополнительно и что именно может обосновать это дополнительное приписывание. Кроме того, если главным в подходе Сёрла является принадлежность к тому же виду, возникает естественный вопрос: какие факторы дают нам основание приписывать понимание (или сознание) внеземным пришельцам, чья биология отлична от нашей? Обижать инопланетян, отказываясь приписывать им понимание до процедуры вскрытия, было бы рискованно.

Ханс Моравек, директор лаборатории робототехники в Университете Карнеги-Меллона и автор книги «Робот: просто машина для трансцендентного сознания», утверждает, что позиция Сёрла всего лишь отражает интуиции традиционной философии сознания, которые не соответствуют новой когнитивной науке. Моравек одобряет версию ОДС. Имеет смысл приписывать интенциональность машинам по тем же причинам, по которым имеет смысл приписывать ее людям. Его «интерпретирующая позиция» аналогична взглядам Дэниела Деннетта. Далее Моравек отмечает, что, кроме всего прочего, мы приписываем другим способность приписывать интенциональность, а затем мы приписываем ее и себе. Именно такая само-репрезентация лежит в основе сознания (consciousness). Похоже, эти способности не зависят от реализации и, следовательно, возможны и для инопланетян, и для соответствующим образом запрограммированных компьютеров.

Вероятно, причина, по которой Сёрл полагает, что мы можем игнорировать это доказательство в случае роботов и компьютеров, заключается в нашем знании о том, что они обрабатывают информацию синтаксически, и этот факт перевешивает все остальные соображения. Действительно, Сёрл верит, что это — более важное соображение, которое китайская комната лишь иллюстрирует. Оно рассматривается в разделе «Синтаксис и семантика» далее.

Ответ от интуиции

Во многих ответах на аргумент китайской комнаты отмечается, что, как и в случае с мельницей Лейбница, этот аргумент основывается на интуиции: на интуиции, что компьютер (или человек в комнате) не способен думать или понимать. Например, Нед Блок (Block 1980) в своем оригинальном комментарии в журнале The Behavioral and Brain Sciences говорит, что «сила аргумента Сёрла покоится на интуиции о том, что некоторые сущности не мыслят». Но, утверждает Блок, (1) интуиции иногда могут и должны быть опровергнуты и (2) возможно, нам следовало бы привести нашу концепцию понимания в соответствие с реальностью, где определенные компьютерные роботы принадлежат к тому же естественному виду, что и люди. Схожим образом Маргарет Боден (Boden 1988) указывает, что мы не можем доверять нашим наивным интуициям о зависимости сознания от материи; развитие науки может изменить наши интуиции. В самом деле, именно желание устранить предвзятость из наших интуиций побудило Тьюринга (1950) предложить свой тест, который не принимал во внимание физический характер отвечающей на вопросы системы. Некоторые из критиков Сёрла, в сущности, утверждают, что он просто перенес доверие к интуиции обратно, в комнату.

Критики утверждают, что наша интуиция относительно интеллекта и понимания может быть ненадежной и, возможно, несовместимой даже с современной наукой. Затрагивая вопросы понимания, Стивен Пинкер в статье «Как работает разум» (1997) утверждает, что «… Сёрл просто изучает факты об английском слове “понимать” ... Люди не хотят использовать это слово, покуда не вступят в силу определенные стереотипические условия…». Но, как утверждает Пинкер, здесь нет никаких научных ставок. Пинкер возражает против обращения Сёрла к «каузальным силам мозга», отмечая, что очевидное местопребывание каузальных способностей — это «паттерны взаимосвязанности, правильным образом обрабатывающие информацию». Пинкер заканчивает свою дискуссию научно-фантастической историей, где пришельцы, анатомически совершенно отличные от людей, обнаруживая, что наши головы заполнены мясом, не могут поверить, что люди способны думать. Интуиция инопланетян ненадежна, что, вероятно, можно сказать и о нашей.

Другие критики также обеспокоены тем, как наше понимание понимания основывается на аргументе китайской комнаты. В своей статье «Китайская комната, которая понимает» исследователи ИИ Саймон и Эйзенштадт (Simon and Eisenstadt 2002) утверждают: в то время как Сёрл опровергает «логически сильный ИИ» — тезис о том, что прошедшая тест Тьюринга программа обязательно будет понимать, — аргумент Сёрла не ставит под сомнение «эмпирический Сильный ИИ» — тезис о том, что мы можем запрограммировать компьютер таким образом, что обычные критерии понимания будут убедительным образом удовлетворены. Тем не менее они считают, что эти вопросы невозможно решить «без использования определения термина “понимать”, которое могло бы обеспечить проверку суждения об истинности или ложности гипотезы». Они цитируют статью «Слово и объект» В.О. Куайна в целях демонстрации того, что в приписывании понимания людям всегда есть эмпирическая неопределенность. Китайская комната — это трюк вроде умного Ганса (умный Ганс — лошадь, которая, как казалось, умела находить ответы на простые арифметические вопросы, однако впоследствии было установлено, что Ганс при ответе мог ориентироваться на бессознательные сигналы своего тренера). Схожим образом, человек в комнате не понимает по-китайски, и его можно разоблачить при внимательном наблюдении. (Саймон и Айзенштадт не объясняют, как можно организовать такое наблюдение или как оно может повлиять на аргумент.) Ссылаясь на работу Рудольфа Карнапа, Саймон и Айзенштадт утверждают, что «понимать» означает не просто демонстрировать определенное поведение, но использовать «намерения» (intensions), которые определяют расширения (extensions), и что в ходе наблюдения за работой реальных программ мы можем увидеть, что они используют соответствующие намерения. Они обсуждают три реальные ИИ-программы и высказываются в пользу различных атрибуций ментальности, включая атрибуцию понимания, делая вывод, что компьютеры понимают. Они изучают «намерения через соединения слов и других языковых структур с их денотатами, обнаруживаемыми посредством сенсорных стимулов». И, поскольку мы можем наблюдать весь процесс работы машин, нам «на самом деле легче установить признаки понимания у машин, чем у людей». Таким образом, заключают они, доказательство эмпирического сильного ИИ неоспоримо.

Схожим образом Дэниел Деннетт в своем первоначальном ответе 1980 года на аргумент Сёрла назвал его «насосом интуиции»: термин, который он придумал в ходе обсуждения аргумента КК с Хофштадером. Взвешенная точка зрения Деннета (2013) состоит в тезисе, что аргумент КК «очевидно ошибочен и вводит в заблуждение …» (320). Пол Тагард (Thagard 2013) предлагает, чтобы для каждого мысленного эксперимента в философии существовал равный и противоположный мысленный эксперимент. Он считает, что интуиции ненадежны и что аргумент КК является тому примером (и что фактически аргумент КК сегодня опровергнут технологией автономных роботизированных автомобилей). Деннетт подробно останавливался на нашей интуиции относительно интеллекта. Деннетта (в работе «Быстрое мышление», 1987) беспокоила низкая скорость, с которой работала бы Китайская комната — это беспокойство разделяли и другие комментаторы, в числе которых были Тим Модлин, Дэвид Чалмерс и Стивен Пинкер. Оператор Китайской комнаты в конечном итоге способен дать соответствующие ответы на вопросы на китайском. Однако те, кто думают медленно, вовсе не разумны, а глупы — и в дикой природе они вполне могли бы умереть. Деннетт утверждает, что «скорость ... имеет “первостепенное значение” для интеллекта. Если вы не можете достаточно быстро разобраться в соответствующих областях изменяющейся среды, чтобы позаботиться о себе, в практическом смысле вы не обладаете разумом, сколь бы сложным вы ни были» (326). Таким образом, Деннетт соотносит интеллект со скоростью обработки информации, которая поступает из актуальной среды. Тим Модлин (1989) с этим не согласен. Модлин рассматривает проблему шкалы времени, на которую указывают другие авторы, и, вопреки Деннетту, делает вывод, что крайняя медлительность вычислительной системы не нарушает каких-либо необходимых условий мышления или сознания.

Стивен Пинкер (1997) также считает, что Сёрл опирается на наивную интуицию. Пинкер одобряет встречный пример Черчлендов (1990) с аналогичным мыслительным экспериментом (человек размахивает магнитом, но свет не возникает), отмечая, что его результат не опровергнет теорию Максвелла, согласно которой свет состоит из электромагнитных волн. Пинкер считает, что первостепенное значение здесь имеет вопрос о скорости: «В этом мысленном эксперименте скорость волн замедляется до отметки, за которой мы, люди, больше не распознаем их как свет. Полагаясь на свою интуицию, мы ошибочно заключаем, что быстрые волны также не могут быть светом. Точно так же Сёрл «замедлил» умственные вычисления до отметки, за которой мы, люди, больше не распознаем их как понимание (поскольку понимание обычно намного быстрее)» (94–95). Говард Гардинер, сторонник выводов Сёрла относительно КК, делает аналогичное замечание относительно понимания. Гардинер анализирует аргумент китайской комнаты в своей книге Новая наука о разуме (1985: 171–177). Он рассматривает все стандартные ответы на аргумент китайской комнаты и приходит к выводу, что Сёрл прав в отношении комнаты: «…в случае китайской комнаты значение слова “понимать” было чрезмерно расширено…» (175).

Таким образом, некоторые из этой группы критиков утверждают, что скорость влияет на нашу готовность приписать интеллект и понимание медленной системе, такой как система китайской комнаты. Результатом данного утверждения может быть всего лишь вывод, что наша интуиция о китайской комнате ненадежна и, следовательно, при реализации программы человек в комнате может понимать китайский язык несмотря на нашу интуицию об обратном (Модлин и Пинкер). Или же мы можем принять скорость в качестве главного фактора, влияющего на наше решение о том, где проходит различие между симуляцией в комнате и действиями быстрого компьютера, придя к заключению, что человек не разумен, тогда как компьютер — да (Деннетт).

Более общие философские проблемы

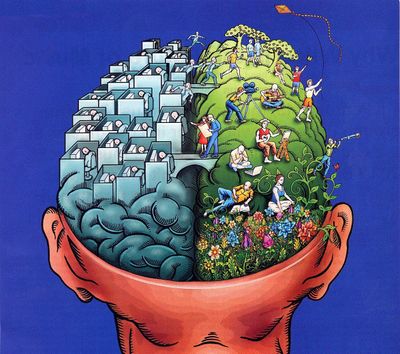

Синтаксис и семантика

Сёрл полагает, что аргумент китайской комнаты говорит в пользу более широкой позиции, которая объясняет неспособность китайской комнаты произвести понимание. Сёрл утверждал, что реализуемые компьютерами программы являются просто синтаксическими. Компьютерные операции являются «формальными» в том смысле, что они реагируют только на физическую форму строк символов, а не на значение символов. С другой стороны, у сознания есть состояния, обладающие значением, ментальным содержанием. Мы ассоциируем значения со словами или знаками в языке. Мы реагируем на знаки в силу их значения, а не только из-за их физических свойств. Короче говоря, мы понимаем. Однако, согласно Сёрлу, это обстоятельство имеет ключевое значение: «Синтаксис сам по себе недостаточен для семантики и не является ее главным элементом». Таким образом, хотя компьютеры и могут быть способны манипулировать синтаксисом для получения соответствующих ответов на ввод из естественного языка, они не понимают предложений, которые они получают или выводят, поскольку не могут связать значения со словами.

Сёрл (1984) предлагает аргумент с тремя посылками: поскольку синтаксис недостаточен для семантики, программы не могут произвести сознания.

Программы являются чисто формальными (синтаксическими).

У человеческого сознания есть ментальное содержание (семантика).

Синтаксис сам по себе недостаточен для семантического содержания и не является для него определяющим элементом.

Следовательно, программы сами по себе недостаточны для сознания и не являются его определяющим элементом.

Мысленный эксперимент китайской комнаты как таковой поддерживает третью посылку. Утверждение о том, что синтаксические манипуляции недостаточны для значения или мышления, является существенной проблемой, которая имеет более широкие импликации, чем проблема ИИ или проблема атрибуции понимания. В главных теориях сознания утверждается, что человеческое познание в целом носит вычислительный характер. Одна из версий гласит, что мысль оперирует с символами ввиду их физических свойств. В альтернативной версии — коннекционизме — утверждается, что вычисления протекают в «субсимволических» в состояниях. Если Сёрл прав, то не только Сильный ИИ, но и эти основные интерпретации человеческого познания ошибочны.

Как мы уже видели, Сёрл настаивает, что сценарий китайской комнаты доказывает невозможность получения семантики из одного лишь синтаксиса. В системах формальной логики, своего рода искусственном языке, правила прописываются для синтаксиса, и данная процедура, по-видимому, совершенно не зависит от семантики. Логик задает базовый набор символов и некоторые правила для работы со строками для создания новых символов. Эти правила являются чисто формальными или синтаксическими: они применяются к строкам символов исключительно в силу синтаксиса или формы последних. Семантика, если таковая имеется, для системы символов должна прописываться отдельно. И тот, кто хочет показать, что между синтаксическими операциями и семантикой устанавливаются любопытные дополнительные отношения, такие, что манипуляции с символами сохраняли бы истинность, должен привести подчас сложные мета-доказательства. Итак, на первый взгляд кажется, что семантика искусственных языков совершенно не зависит от синтаксиса и что получить семантику только лишь из синтаксиса невозможно. «Самих по себе формальных символов никогда не может быть достаточно для ментального содержания, поскольку символы по определению не обладают значением (или интерпретацией, или семантикой), за исключением случаев, когда некто извне комнаты им его приписывает» (Searle 1989: 45).

Отождествление значения с интерпретацией в этом отрывке очень важно. Идея Сёрла явно верна в отношении каузально инертных формальных систем, которые предлагают логики. Однако, когда мы переходим от формальных систем к вычислительным системам, ситуация усложняется. Как отмечают многие критики Сёрла (напр., Cole 1984, Dennett 1987, Boden 1988 и Чалмерс 1996), запускающий программу компьютер отличается от «только лишь синтаксиса». Компьютер — чрезвычайно сложная электронная каузальная система. Изменения состояния в системе носят физический характер. Можно интерпретировать физические состояния, например, электрическое напряжение, как синтаксические 1 и 0, но их внутренняя реальность все равно является электронной, а синтаксис «производен», то есть является продуктом интерпретации. Состояния синтаксически определяются программистами, но в основном они являются состояниями сложной каузальной системы, встроенной в реальный мир. Это сильно отличается от абстрактных формальных систем, которые изучают логики. Деннетт отмечает, что никакая «компьютерная программа сама по себе» (язык Сёрла) — например, программа, лежащая на полке — не может быть причиной чего бы то ни было, даже простого сложения, не говоря уже о ментальных состояниях. Программа должна быть запущена. Чалмерс (1996) предлагает пародию, в которой доказывается, что рецепты — синтаксичны, синтаксис недостаточен для рассыпчатости, пирожки — рассыпчаты, поэтому реализации рецепта недостаточно для изготовления пирога. Деннетт (1987) резюмирует проблему следующим образом: «позиция Сёрла, таким образом, приобретает следующим вид: возьмем материальный объект (любой материальный объект), неспособный генерировать ментальные явления. Вы не сможете, просто перепрограммировав его, придать ему способность генерировать ментальные явления, то есть реорганизуя условные зависимости переходов между его состояниями». Деннет считает, что «именно программирование могло бы наделить какую-либо сущность сознанием». Однако Деннетт утверждает, что в реальности «эмпирически маловероятно, что правильные программы будут запущены на чем-либо, кроме органического человеческого мозга» (325–6).

Еще одна связанная с этим сложность заключается в следующем: далеко не очевидно, что компьютеры выполняют синтаксические операции в том же смысле, что и человек. То есть не очевидно, что компьютер понимает синтаксис или синтаксические операции. Компьютер не знает, что он манипулирует с 1 и 0. Компьютер, в отличие от человека в китайской комнате, не распознает, что его строки двоичных данных имеют определенную форму и что, следовательно, к ним могут применяться определенные синтаксические правила. Внутри компьютера нет ничего, что буквально считывало бы входные данные или что «знало» бы, что такое символы. Вместо этого в нем работают миллионы транзисторов, ответственных за изменение состояний. Последовательность напряжений изменяет ход выполнения операций. Мы, люди, можем интерпретировать эти напряжения как двоичные числа, а изменения напряжения — как синтаксические операции, но компьютер не интерпретирует свои операции как синтаксические или какие-либо иные. Поэтому, возможно, компьютеру не нужно переходить от синтаксиса к семантике, чему возражает Сёрл. Ему необходимо перейти от сложных каузальных связей к семантике. Кроме того, возможно, что любую каузальную систему можно описать как выполнение синтаксических операций: если мы интерпретируем светлый квадрат как логический «0», а темный квадрат как логический «1», то кухонный тостер может быть описан как устройство, переписывающее логические «0» на логические «1».

В 1990-х годах Сёрл начал использовать связанные с этим соображения для демонстрации того, вычислительные подходы не просто ложны, но лишены четкого смысла. Вычисления, или синтаксис, «зависят от наблюдателя», а не являются неотъемлемой чертой реальности: «… вы можете давать “вычислительную интерпретацию” чему угодно» (Searle 2002b: 17), даже молекулам настенной краски. Поскольку ничто по сути своей не является вычислительным, у нас не может быть научной теории, которая сводит ментальное, не зависящее от наблюдателя, к вычислению, которое, напротив, от него зависит. «Вычисление существует только относительно какого-либо агента или наблюдателя, который применяет вычислительную интерпретацию к тому или иному явлению. Это очевидный момент. Я должен был понять это еще десять лет назад, но не понял» (Searle 2002b: 17, первоначально опубликовано в 1993).

Критики отмечают, что стены не являются компьютерами; в отличие от стены, компьютер проходит ряд состояний, которые контрафактически описываются программой (Chalmers 1996, Block 2002, Haugeland 2002). В своей статье 2002 года Блок рассматривает вопрос о том, является ли стена компьютером (в ответ на обвинение Сёрла, что все, размещенное в формальной системе, является формальной системой, тогда как с сознанием дело обстоит иначе). Блок отрицает, что ответ на вопрос, является ли нечто компьютером, полностью зависит от нашей интерпретации. Он отмечает, что Сёрл игнорирует контрафактические построения, которые должны быть верны для реализующей системы. Схожим образом Хаугеланд (Haugeland 2002) подчеркивает, что реализация будет каузальным процессом, надежно осуществляющим операции, каковые должны обладать надлежащей казуальной силой. Блок заключает, что аргументы Сёрла терпят крах, но признает, что с их помощью «нам удается лучше понять природу интенциональности и ее связи с вычислением и репрезентацией» (78).

Рей (Rey 2002) также обращается к аргументам Сёрла о том, что синтаксис и символы суть свойства, зависящие от наблюдателя, а не нечто физическое. Сёрл выводит это из того факта, что у них нет физического определения. Однако из этого вовсе не следует, что они являются зависимыми от наблюдателя. Рей утверждает также, что Сёрл неправильно понимает реализацию программу. Рей соглашается с ответом Чалмерса Патнэму: реализация — это не просто структурное отображение, она запускает каузацию, поддерживающую контрафактические построения. «Это так часто упускается из виду, что стоит повторить: синтаксически специфицируемые объекты, для которых определяются вычисления, могут обладать и как правило обладают семантикой; просто семантика не участвует в спецификации». Состояния человека имеют свою семантику благодаря их вычислительной организации и их каузальным связям с миром. Рей заключает: Сёрл «просто не учитывает существенных ресурсов функционализма и сильного ИИ». (222) Рассказ, содержащий правдоподобные детали, умерил бы остроту негативных выводов, сделанных из поверхностного наброска системы в китайской комнате.

Джон Хаугеланд (Haugeland 2002) утверждает, что в определенном смысле процессор должен понимать команды в запускаемых им программах: он выполняет их в соответствии со спецификациями. «Понять компьютер как выполнение программы мы можем единственно допустив, что его процессор реагирует на имеющие для него смысл предписания программы» (385). Таким образом, символы операций имеют смысл для системы. Хаугеланд продолжает проводить различие между узкой и широкой системой. Он утверждает, что данные могут иметь семантику в широкой системе, которая включает в себя репрезентации внешних объектов, производимые датчиками. Попутно Хаугеланд делает необычное заявление, которое он доказывает в другом месте: подлинный интеллект и семантика предполагают наличие «способности следовать некоей жизненной ориентации», каковая не является пропозициональной, иными словами, — способности любить (ср. фильм Стивена Спилберга 2001 года «Искусственный интеллект»).