Риск

С 1970-х годов исследования риска превратились в крупную междисциплинарную область науки. Хотя проблема риска занимала сравнительно немногих философов, существуют важные взаимосвязи между такого рода исследованиями и некоторыми философскими дисциплинами.

Здесь мы попытаемся дать обобщенное представление наиболее проработанных из этих взаимосвязей, а также ряда ключевых тем философии риска. Статья состоит из шести разделов, в которых дается определение риска и предлагаются его различные трактовки с точки зрения эпистемологии, философии науки, философии техники, этики и философии экономики.

Определение риска

В неспециализированном контексте слово «риск» относится, пусть зачастую и неопределенно, к ситуациям, когда возможно (но не обязательно) возникновение некоторых нежелательных событий. В специальном контексте слово имеет некоторые более конкретизированные значения и области применения. Пять из них представляют особый интерес, поскольку широко используются в нескольких отраслях:

1. риск = нежелательное событие, которое может произойти или не произойти.

Пример использования: «Рак легких — один из главных рисков для курильщиков».

2. риск = фактор, ведущий к нежелательным событиям, которые могут произойти или не произойти.

Пример использования: «Курение является, безусловно, самым большим риском для здоровья в индустриальных странах» (нежелательное событие в данном случае — это болезнь, вызываемая курением). Как (1), так и (2) определяют риск в качественном смысле.

У этого слова также есть и количественное значение, старейшее его определение:

3. риск = вероятность нежелательного события, которое может произойти или не произойти.

Использование такого определения можно проиллюстрировать следующим примером: «Риск того, что жизнь курильщика сократится от болезней, связанных с курением, составляет 50 %».

4. риск = статистически ожидаемое значение нежелательного события, которое может произойти или не произойти.

Ожидаемое значение возможного негативного события — произведение его вероятности и оценки степени его опасности.

Зачастую используют число погибших в качестве показателя степени опасности происшествия.

С таким показателем степени опасности «риск» (согласно определению 4), связанный с потенциальным происшествием, выражается статистически ожидаемым числом смертей. Прочие показатели риска обусловливаются иными оценками степени опасности.

Хотя оценка ожидаемых значений применяется начиная с XVII века, использовать для этого термин «риск» стали относительно недавно. Началом такого использования можно считать анализ риска в известном исследовании по безопасности ядерного реактора WASH-1400 (Rasmussen et al. 1975, Rechard 1999).

В наше время это уже стало стандартным специальным значением термина «риск» во многих отраслях. По мнению некоторых аналитиков риска, таково единственно верное употребление термина.

5. риск = тот факт, что решение принимается в условиях известных вероятностей («решение в условиях риска» в противоположность «решению в условиях неопределенности»)

Помимо этих пяти общепринятых значений «риска» существуют несколько других, более технических, которые закрепились в отдельных специализированных отраслях. Некоторые из основных определений риска, используемые в экономическом анализе, будут представлены в разделе 6.1.

Хотя большинство приведенных выше определений термина «риск» используются философами, значительная часть философской литературы, посвященной риску, обращается к данному понятию, скорее, в неформальном плане, о чем говорилось в начале раздела, а именно трактуя его в качестве такого положения вещей, когда нежелательное событие может произойти или не произойти.

Некоторые философы критиковали специальные определения риска за их чрезмерную ограниченность и недостаточный охват аспектов, которые должны быть включены в процесс оценки риска (Buchak 2014, Pritchard 2015, Shrader-Frechette 1991). Лингвистические данные указывают на то, что специальные определения риска фактически не повлияли на неспециальное употребление слова (Boholm et al. 2016).

Терминологическое примечание. Некоторые философы разграничивают понятия «субъективной» и «объективной» вероятности. Другие рассматривают термин «вероятность» в смысле субъективной оценки. Здесь используется первая формулировка, то есть вероятность может относиться как к субъективной вероятности, так и к объективным шансам.

Эпистемология

Когда присутствует риск, должно существовать нечто неизвестное или что-то с неизвестным исходом. Таким образом, знание о риске есть знание о недостатке знания. Сочетанием знания и такого рода незнания обусловлена сложность проблематики риска с эпистемологической точки зрения.

В контексте теории принятия решений термин употребляется в более строгом значении. Согласно этой теории, о решении говорится, что оно принимается «в условиях риска», если имеются соответствующие вероятности, и «в условиях неопределенности», если они отсутствуют или доступны лишь частично.

Частично определенные вероятности порой выражаются интервалами вероятности, как, например, «вероятность того, что завтра будет дождь, колеблется от 0,1 до 0,4» (термин «решение в условиях незнания» иногда употребляется по отношению к случаю, когда отсутствует любая вероятностная информация).

Хотя различение риска и неопределенности полезно с точки зрения теории принятия решений, в эпистемологии оно требует пояснения. Очень редко о вероятностях можно судить с определенностью.

Строго говоря, кажется, что единственными четко выраженными примерами «риска» (с известными вероятностями) являются идеальные события из учебника, которые отсылают к таким заведомо прозрачным инструментам, как игральная кость или монетка.

В ситуациях из реальной жизни, даже если мы действуем в соответствии с заданной оценкой вероятности, мы не можем быть уверены, что оценка совершенно точна, из-за чего и возникает неопределенность. Отсюда следует, что почти все решения принимаются «в условиях неопределенности».

Если проблема принятия решения рассматривается как решение «в условиях риска», это не значит, что данное решение принято в условиях абсолютно известной вероятности. Скорее, выбор был сделан в пользу того, чтобы упростить проблему принятия решения, когда оно рассматривается как случай известной вероятности. Зачастую это является крайне полезной идеализацией в теории принятия решений.

Однако при практическом применении важно различать те вероятности, которые можно считать известными, и те, которые неизвестны и, таким образом, нуждаются в дальнейшей корректировке. Типичный пример первых — частота отказов техники, которая измеряется на основе продолжительного и хорошо задокументированного опыта использования. Другой случай выражается в экспертных оценках ожидаемой частоты отказов технических деталей нового типа.

Каждая из этих систем содержит так много компонентов и потенциальных взаимодействий, что важные характеристики ее поведения становится невозможно предсказать. Однако несмотря на фундаментальную неопределенность, можно сделать достаточно надежные заключения о некоторых аспектах систем. Эпистемологический статус таких заключений и связанный с ними характер неопределенности все еще нуждаются в дальнейшем пояснении (McKinney 1996, Shrader-Frechette 1997).

В науках о риске, как правило, разделяют «объективный риск» и «субъективный риск». Первое понятие по существу не вызывает особых проблем, поскольку оно относится к частотному подходу к вероятностям. Другое представляется более неоднозначным. В ранних психометрических работах о риске 1970-х годов субъективный риск зачастую воспринимался как субъективная оценка объективного риска.

В недавних трудах формируются более сложная картина. Субъективные оценки (серьезности) риска зависят от большого количества факторов, которые не охвачены традиционными системами измерения объективного риска (такими как контроль и вмешательство в природу). Если термины воспринимаются в таком смысле, на субъективный риск влияют субъективные оценки объективного риска, но его нельзя с ним отождествлять.

В психологической литературе субъективный риск зачастую воспринимается как общее суждение индивида в отношении серьезности опасности или возможной опасности. Такие индивидуальные суждения зачастую называются «восприятием риска», но, строго говоря, термин вводит в заблуждение. Вопрос состоит не в восприятии, а скорее в установках и ожиданиях.

Субъективный риск можно изучать с использованием методов измерения установок и психологического масштабирования (Sjöberg 2004).

Философия науки

Роль ценностей в науке довольно-таки противоречива, особенно когда дело касается проблемы риска.

Оценка риска зачастую критиковалась за включение «скрытых» ценностей, которые стимулировали слишком высокую степень принятия риска (Cranor 2016; 2017; Intemann 2016; Heinzerling 2000). Также обсуждалась необходимость усилить воздействие определенных ценностей в оценке риска, таких как справедливость (Shrader-Frechette 2005a), права человека (Shrader-Frechette 2005b) и права и благосостояние человечества будущего (Caney 2009, Ng 2005).

Проблемы риска также приводили к горячим дискуссиям на тему того, в какой степени данные науки должны влиять на стратегические решения. Научные критерии доказательства обычно приводят к сложностям, применяется ли научный подход к решению практических проблем, которые требуют стандартов доказательства, или к иным данным ненаучного характера.

Решение принять или отклонить научное высказывание (например, гипотезу) на практике всегда зависит от возможности совершения ошибки.

Шанс такой ошибки обычно называется индуктивным риском (Hempel 1965: 92). Существует два основных типа ошибок.

Ошибки типа I состоят в выводе, что существует какое-либо явление или действие, которых на самом деле нет. Это ложноположительная ошибка. Ошибки типа II заключаются в том, что существующее явление или действие упускается из виду. Это ложноотрицательная ошибка. В научном мире ошибки типа I, как правило, считаются более проблематичными, чем ошибки типа II. Общепринятые научные стандарты статистической значимости существенно снижают риск ошибок типа I, но и не защищают от ошибок типа II (Shrader-Frechette 2008; John 2017).

Многие споры относительно оценки риска касаются баланса между рисками ошибок типа I и типа II. В то время, как наука предпочитает скорее избегать ошибок типа I, чем ошибок типа II, баланс может пошатнуться, когда ошибки имеют практические последствия.

Примером можно взять случай, когда неизвестно, имеется ли в двигателе самолета серьезный дефект.

Ошибка типа II, то есть действие с расчетом на то, что дефекта не существует, когда на самом деле он присутствует, в данном случае будет считаться опаснее ошибки типа I, действия с расчетом на то, что дефект существует, когда на самом деле его нет. (Разница между ошибками типа I и типа II зависит от границ изучаемого нами последствия. В обсуждении риска грани в основном четко определены; см. Lemons et al. 1997, van den Belt and Gremmen 2002.)

В данном конкретном случае несомненно, что приоритет должен быть отдан избеганию ошибки типа II, а не ошибки типа I.

Другими словами, лучше отложить полет и убедиться, что двигатель в порядке, чем лететь с двигателем, который окажется неисправным. Однако в большинстве случаев баланс между двумя типами более проблематичен и вызывает споры. Обычно разногласия касаются вопроса о том, какой объем сведений требуется для мер, предпринимаемых против возможного отрицательного воздействия химических веществ на человеческое здоровье и окружающую среду.

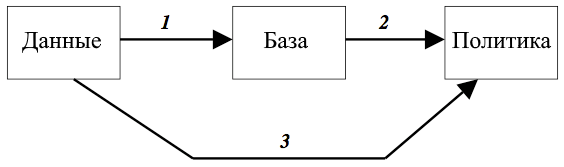

Рис. 1. Использование научных данных для формирования политик.

Разногласия могут быть устранены при помощи простой, но наглядной модели того, как научные данные влияют на научные суждения и практические решения (Hansson 2008). Научное знание начинается с данных, получаемых в результате экспериментов и других наблюдений. (См. рис. 1). В процессе критической оценки эти данные приводят к появлению научной базы (стрелка 1). Грубо говоря, база состоит из утверждений, которые в настоящее время могут быть обоснованно и без оговорок занесены в (достаточно подробное) научное руководство.

При решении, следует или нет на данный момент заносить научную гипотезу в базу, бремя доказательства ложится на ее сторонников. Точно так же те, кто заявляют о существовании до сих пор недоказанного явления, несут на себе бремя доказательства. Подобные стандарты доказательства важны для целостности науки.

Наиболее очевидный способ использования научной информации для формирования политики заключается в применении сведений из базы (стрелка 2).

Во многих случаях это единственно разумный выход. Однако в управлении рисками решения, которые опираются исключительно на базу, могут привести к нежелательным последствиям.

Предположим, что проводится токсикологическое обследование вещества, до сих пор неизученного с токсикологической точки зрения.

Обследование не привело к определенным результатам. Отсюда научно обоснованное сомнение, что вещество может быть опасным для человеческого здоровья, но для этого вывода нет достаточных научных доказательств. Поскольку нет достаточных данных, чтобы с полным основанием включить их в научную базу, то эта информация не может повлиять на принятие мер стандартным путем (стрелки 1 и 2).

Имеется строгое требование избегать ошибок типа I в процессе, представленном стрелкой 1. Данный процесс отделяет информацию, которая в этом случае могла бы иметь практическое значение и обосновывала бы определенные защитные меры.

В таких случаях можно говорить о прямом пути от данных к принятию мер (пункт 3).

Это означает, что баланс между ошибками типа I и типа II определяется в конкретном случае на основе практических рекомендаций, а не стандартной научной процедуры с ее упором на избегание ошибок типа I.

Крайне важно различать две разновидности процессов принятия решений, связанных с риском. Один процесс заключается в определении того, какие утверждения о рисках должны быть включены в научную базу.

Другой состоит в определении того, как связанная с риском информация должна влиять на практические меры по защите здоровья и окружающей среды.

Было бы странно, если критерии доказательства обоих разновидностей процессов по принятию решений совпадали. Веские основания приводятся для строгих стандартов научного доказательства, например высокий порог вхождения для базы. В то же время могут существовать веские стратегические основания для того, чтобы на решения по управлению рисками оказывали влияния эффективные научные показатели опасности, которые еще недостаточно укрепились, чтобы включать их в научную базу.

Проблемы стратегии, связанные с риском, зачастую становились мишенью для широкомасштабных кампаний по дезинформации, для которых характерно отрицание науки и другие признаки псевдонаучности (Oreskes 2010).

Некоторые философы принимали активное участие в опровержении необоснованных утверждений и защите науки по вопросам, связанных с риском (Cranor 2005, 2016, 2017; Goodwin 2009, Prothero 2013, Shrader-Frechette 2014, Hansson 2017).

Философия техники

Безопасность и предотвращение риска составляют главную проблему в инженерно-технической сфере. Техника безопасности все чаще становится предметом теоретических разработок.

Однако научные дискуссии по этой теме в основном носят разрозненный характер в силу распыленности среди различных технических областей. Одни и те же базовые идеи, или так называемые «философии безопасности», в химической, ядерной и электрической инженерии, к примеру, обсуждаются под разными именами. Тем не менее базовые представления схожи в различных областях инженерного обеспечения безопасности (Möller and Hansson 2008).

Простые принципы безопасности, зачастую представленные в виде общих правил, играют центральную роль в инженерном обеспечении безопасности. Три наиболее важных из них: естественная безопасность, факторы безопасности и многочисленные препятствия.

Естественная безопасность, или так называемая первичная профилактика, заключается в устранении опасности. Она отличается от вторичной профилактики, которая заключается в снижении риска, связанного с опасностью. В качестве простого примера представьте процесс, в котором используются огнеопасные материалы.

Естественная безопасность будет заключаться в замене их на невоспламеняющиеся материалы. Вторичная профилактика будет состоять в устранении или изоляции источников возгорания и/или установке средств пожаротушения. Как показано в примере, вторичная профилактика обычно включает дополнительное аварийно-спасательное оборудование.

Факторы безопасности — это количественные коэффициенты, применяемые или используемые в процессе проектирования наших домов, мостов, автомобилей, инструментов и т.п. для обеспечения того, чтобы сооружения были крепче минимума, который ожидается для их функционирования.

Сложные системы факторов безопасности определяются нормами и стандартами. Фактор безопасности чаще всего определяется как соотношение между степенью максимальной нагрузки, которая не приведет к определенному виду ошибки, и соответствующей степенью максимально ожидаемой нагрузки. Как правило, мосты и другие конструкции способны выдержать нагрузку, вдвое, а то и втрое превышающую ожидаемую максимальную. Это значит, что применяется двойная или тройная безопасность.

Защитные ограждения зачастую соединяются в цепи. В идеале каждое ограждение не зависит от предыдущего, так что если первое разрушится, второе останется нетронутым и т.д.

Например, в случае древних крепостей, если врагу удалось прорваться через первую стену, дополнительные ограждения защитят обороняющихся. Некоторые инженерные барьеры безопасности следуют тому же принципу концентрических физических барьеров. Другие следуют той же схеме, но уже скорее во временном и функциональном, чем в пространственном смысле.

Один из таких уроков, который инженеры вынесли из крушения Титаника, показал, что усиленная конструкция первых барьеров не поможет, если она ведет к пренебрежению другими барьерами (в данном случае — спасательными шлюпками).

Основная проблема конструирования барьеров безопасности заключается в том, как сделать их как можно более независимыми друг от друга. Если два или более барьера уязвимы к одному и тому же типу воздействия, тогда одна разрушительная сила может разрушить каждый из них за один раз. Например, если три защитных клапана установлены в одном и том же заводском помещении, каждый с вероятностью сбоя 1/1000, отсюда не следует, что вероятность разрушения всех трех составляет 1×10−9. Три клапана могут быть уничтожены одним пожаром или разрушены вследствие одной ошибки в ходе технического обслуживания.

Это характерно для многих типов оборудования.

Естественная безопасность, факторы безопасности и многочисленные препятствия обладают одной общей особенностью — они все направлены на защиту не только от рисков, которым могут быть приписаны определенные оценки вероятности, но также от опасностей, вероятность которых рассчитать невозможно, например возможность возникновения какого-то непредвиденного явления, которое приведет к аварии.

Тем не менее философам техники все еще предстоит более детально исследовать принципы, лежащие в основе техники безопасности, и объяснить, как они соотносятся с другими принципами инженерного проектирования (Doorn and Hansson 2015).

Было предпринято множество попыток предугадать риски, связанные с зарождающимися и будущими технологиями. Роль философов в этих усилиях зачастую заключается в поиске сложностей и неопределенностей, связанных с такого рода предсказаниями (Allhoff 2009; Gordijn 2005).

Как показывает опыт, даже после серьезных усилий, потраченных на укрепление защиты нового продукта, остается необходимость в послерыночном надзоре (post market surveillance, PMS) с целью обнаружения неожиданных проблем.

Например, перед массовым запуском автомобильных подушек безопасности приблизительно в 1990 году инженеры по безопасности выполняли лабораторные испытания различных аварийных сценариев с использованием манекенов разного веса и формы (включая манекены детей и беременных женщин). Но данные исследования вместо улучшения конструкции привели к тому, что срабатывание подушек безопасности вызывало значительное количество (в основном небольших) повреждений.

Тщательно анализируя реальные аварии, инженеры смогли значительно сократить частоту и тяжесть таких травм (Wetmore 2008). В случае лекарственных препаратов и некоторых медицинских изделий послерыночный надзор является обязательным по закону во многих юрисдикциях.

Этика

Проблемы теории морали

До недавнего времени философия морали не подходила к проблемам риска системно. Возможное объяснение этого недостатка состоит в том, что в анализе сложностей, к которым приводят индетерминизм и недостаток знания в реальной жизни, моральная философия готова была отойти на второй план, уступая место теории принятия решений

. Согласно традиционному разделению зоны ответственности между этими двумя дисциплинами, моральная философия дает оценку человеческому поведению в точно определенных ситуациях. Теория принятия решений, в свою очередь, принимает во внимание экспертные оценки рассматриваемых случаев, добавляет доступную вероятностную информацию и выдает свою оценку рациональному поведению в изменчивом и индетерминистском мире.

С этой позиции нет необходимости в дополнительных моральных ценностях для работы с индетерминизмом или недостатком знания, поскольку теория принятия решений оперирует исключительно рациональными критериями.

Примеры, отражающие спорный характер разграничения двух дисциплин, обнаруживаются легко.

Сравните сбрасывание кирпича на человека с высотного здания с тем, когда мы совершаем то же действие, предварительно не убедившись, что внизу нет никого, в кого может попасть кирпич.

Моральная разница между двумя действиями не может быть очевидным образом выражена путем исчисления вероятностей. Этический анализ такой разницы должен обратиться к моральным аспектам принятия риска, в отличие от оценки намеренного причинения вреда.

В более широком смысле достаточный и адекватный обзор этики риска должен проводить различие между подверженностью риску по своей или не по своей воле и тем, когда человек сам идет на риск; между рисками, коим подвергается человек, который согласен рисковать, и рисками, которым подвергается человек, на это не согласный.

Оно не может быть проведено в рамках аппарата, который рассматривает риск как вероятностную смесь последствий. В принципе последствия могут быть настолько широко определены, что они будут включать все соответствующие моральные аспекты, в том числе нарушения прав, а также намерение и иные сопутствующие ментальные состояния.

Однако они все еще не охватывают моральные импликации принятия риска per se, поскольку он не является чем-то внутренне присущим любому из возможных последствий.

Необходимы методы морального анализа, которые ориентировали бы нас в решениях относительно того, чтобы пойти на риск или подвергнуть кого-то риску. В первую очередь нужно исследовать, как стандартные теории морали могут справиться с проблемами риска — теми же самыми проблемами, с которыми имеет дело теория принятия решений, — а именно: как осуществляется (моральная) оценка вероятностного сочетания (детерминистских) сценариев.

Утилитаризм

В утилитаристской теории существует два очевидных подхода к такого рода проблемам.

Первый — актуалистское решение. Оно заключается в приписывании (вероятностному) сочетанию потенциальных исходов показателя полезности, равного полезности того исхода, который действительно произошел.

Для понимания подхода рассмотрим процесс принятия решения о том, укреплять или не укреплять мост, прежде чем он будет использоваться для проезда одного очень тяжелого транспортного средства. Существует 50 % риск, что мост обрушится, если не будет укреплен.

Допустим, что было принято решение не укреплять мост, и все закончилось благополучно — мост не был поврежден. Согласно актуалистскому подходу, решение оказалось верным. Разумеется, это противоречит обычным моральным представлениям.

Другой устоявшийся утилитаристский подход состоит в максимизации ожидаемой полезности.

Его идея состоит в том, что полезность сочетания потенциальных исходов определяется как средневзвешенная вероятность полезностей исходов.

Критерий ожидаемой полезности подвергался критике по нескольким направлениям. Одно из замечаний состоит в том, что он отвергает обычное проявление предусмотрительности, которое выражается в несоразмерном стремлении избежать крупных катастроф.

Например, при условии, что человеческие смерти равноценны и аддитивны, как полагают многие утилитаристы, данный подход не позволяет предпочесть вероятность 1 к 1000, что один человек умрет, вероятности 1 к 100 000, что умрут пятьдесят человек. Концепция ожидаемой полезности также подвергается критике за то, что она отвергает общее стремление к справедливому распределению риска, то есть предписывает каждому по отдельности несоразмерное уклонение от рисков более высокой вероятности.

Ведь в таком случае при выборе между тем, чтобы один человек столкнулся с вероятностью гибели в 0,9 и тем, чтобы каждый из ста человек столкнулся с вероятностью погибнуть в 0,01, она требует выбрать первый вариант. Иными словами, в целях максимизации ожидаемой полезности запрещается идти на поводу у моральной точки зрения в вопросах принятия риска и подвергания риску.

Однако следует отметить, что из утилитаризма необязательно вытекает критерий ожидаемой полезности. Утилитаризм в широком смысле (Scanlon 1982) сочетается с другими способами оценки неопределенных исходов (прежде всего с утилитаризмом реальных последствий, но в принципе также и для случаев с максиминным критерием). Так или иначе, критика, направленная в отношении максимизации ожидаемой полезности, необязательно демонстрирует изъяны утилитаристского подхода как такового.

Теории морали с опорой на права человека

Проблема рассмотрения риска с точки зрения моральных теорий, которые опираются на права человека, была сформулирована Робертом Нозиком: «Каков уровень, начиная с которого вероятность ущерба, нарушающего чьи-то права, сама является нарушением прав?» (Нозик 2008: 104).

Распространение моральной теории с опорой на права человека на недетерминированные случаи может быть достигнуто путем предписания, что если A имеет право на то, чтобы B не стал причиной определенного исхода, тогда A также имеет право на то, чтобы B не выполнил никакое действие, которое (даже в малейшей степени) повысило бы вероятность такого исхода. К сожалению, такое строгое расширение прав несостоятельно в социальной практике.

Предположим, что A обладает правом не быть убитым B. Однако не представляется разумным распространять это правило на все действия B, которые приводят к малейшему риску умереть для A (например, водить машину в городе, где живет A). Такая строгая интерпретация сделала бы жизнь человеческого общества невозможной.

Стало быть, право не быть подвергнутым риску должно быть оспоримым таким образом, чтобы оно могло быть отменено в некоторых (но необязательно всех) случаях, когда повышение вероятности крайне мало.

Однако остается найти надежный критерий того, когда оно может быть отменено. Как отметил Нозик, лимит вероятности не заслуживает доверия в традиции, «с точки зрения которой украсть у человека пенни, булавку или любой другой сколь угодно мелкий предмет — это нарушение прав. Эта традиция не устанавливает нижнее пороговое значение ущерба в случае, когда ущерб гарантирован» (Нозик 2008: 104).

Деонтологические теории морали

Проблематика рисков, рассмотренная с позиции деонтологических теорий, аналогична соответствующим подходам в концепции с опорой на права человека. Обязательство не причинять вред другому человеку может быть расширено до обязательства не осуществлять действия, которые повысят риск причинения вреда окружающим.

Однако общество, каким мы его знаем, невозможно без исключений из этого правила. Установление критериев для таких исключений вызывает определенные проблемы, как и в случае теорий с опорой на права человека. Все рациональные системы моральных обязательств будут так или иначе содержать общий запрет на действия, которые приведут к смерти другого человека. Такой запрет может (и должен) распространяться на действия, сопряженные с большим риском того, что человек будет убит.

Однако оно не может распространяться на все действия, которые приводят к незначительной степени риска, что человек будет убит, поскольку в таком случае невозможно будет, к примеру, водить машину. Должна существовать грань между разумным и неразумным подверганием риску. Вероятно, такие ограничения должны быть применимы, например, к понятиям вероятности и/или размера выгоды, получаемой в результате решения принять риск. При этом такого рода понятия не имеют прямого отношения ко внутреннему содержанию деонтологических теорий.

Договорные теории

Договорные теории могут показаться более многообещающими по сравнению с теориями, приведенными выше. Критерий, который они предлагают для детерминистского случая, а именно согласие всех сторон, также может быть применен к вариантам выбора, связанных с риском.

Можно было бы сказать, что наложение риска допустимо тогда и только тогда, когда его поддерживают консенсусом. Такой консенсус, как предусмотрено договорными теориями, бывает реальным или гипотетическим.

Реальный консенсус представляется невозможным в сложном обществе, где каждый оказывает минимальный, но суммируемый эффект на жизнь окружающих.

Согласно логическому условию реального консенсуса, любой гражданин может наложить вето на решение любого другого гражданина, решившего водить машину в городе, где он живет. Таким образом, граждане могут блокировать решения друг друга, и общество окажется в патовой ситуации.

Гипотетический консенсус был разработан в качестве критерия для договорной теории в целях решения межиндивидуальных проблем. Предлагается представить гипотетическую ситуацию, при которой устройство будущего общества еще не определено. Когда будущие граждане соберутся выбирать общественный порядок, никто из них не будет знать своего положения в обществе, которое они могут выбрать. Согласно теории справедливости Джона Ролза, они примут решение в соответствии с правилом максимина, то есть изберут социальный порядок, при котором худшее положение в обществе настолько благополучно, насколько это возможно.

Приводя доводы в пользу такого решения, Ролз в основном опирался на предположение, что никто из участников не имеет ни малейшего представления о том, с какой вероятностью он окажется в том или другом положении при будущем общественном порядке (Rawls 1957, 1971; Ролз 2010). Джон Харсаньи, затронувший данную проблему до Ролза, предположил, что вероятность занять определенное социальное положение равна доле населения, которая занимает обозначенную позицию, и что это также известно всем участникам.

Таким образом, если пятая часть населения определенного типа общества станет работниками-мигрантами, тогда каждый участник, согласно начальной ситуации, предложенной Харсаньи, может предположить, что существует большая вероятность стать работником-мигрантом, тогда как согласно исходному положению, предложенному Ролзом, никто из участников не будет иметь представления о вероятностях.

В начальном положении по Харсаньи участники выберут общественный порядок с высокой степенью ожидаемой полезности (вероятностно-взвешенная полезность), а значит, примут во внимания все потенциально возможные позиции, а не только самые неблагоприятные (Harsanyi 1953, 1955, 1975).

Однако в обсуждении различных рисков в нашем обществе рассуждения о гипотетических начальных положениях договорной теории не представляются полезными. Риски и неопределенности реальной жизни обладают иной природой, нежели гипотетическая неопределенность (или незнание) в отношении своего социального положения и условий, имеющих ключевое значение в исходной ситуации.

Данный мысленный эксперимент с исходной ситуацией, по-видимому, не предоставляет нам никаких интеллектуальных инструментов для моральной оценки рисков вдобавок к тем, что имеются у нас, даже если мы никак не пытаемся размышлять о себе отстраненно.

Обзор и перспективы

В общем и целом проблема оценки рисков с моральной точки зрения, по всей видимости, не имеет удовлетворительного решения в стандартных версиях вышеупомянутых типов моральных теорий. Ниже приведены три возможных шага к такому решению:

1. Вероятно, полезным будет сместить акцент с риска, выраженного двумерно в виде вероятности и степени опасности (или одномерно в виде их произведения), на действия по принятию риска и подверганию риску.

Такие действия обладают множеством моральных параметров вдобавок к упомянутым двум. Например, чьими действиями обусловлено возникновение риска и каким именно образом, какая здесь преследуется цель? Или в каком соотношении находятся риск и выгоды, которые он обещает?

2. Также следует учесть важные моральные интуиции посредством допущения, что каждый человек прежде всего обладает моральным правом не подвергаться риску с негативными последствиями, такими как угроза здоровью или имуществу, причиной которого являются действия окружающих.

Однако это первостепенное право должно быть отвергнуто в некоторых случаях, чтобы сделать общественную жизнь возможной в принципе. Таким образом, признание этого права приводит к появлению так называемой проблемы исключения, то есть задачи по определению того, когда этим правом будет справедливо пренебречь.

3. Часть решения проблемы исключения может достигаться с учетом взаимного обмена рисками и выгодами.

Следовательно, если A дозволяется водить машину, подвергая B определенным рискам, тогда взамен B разрешается водить машину, подвергая A схожему риску.

Для разрешения сложных проблем современного общества этот принцип также следует применить к обмену разноплановыми рисками и преимуществами. Значит, подвергание человека риску может считаться допустимым, если это часть справедливой социальной системы принятия риска, которая работает ему во благо (такой системе могут понадобиться механизмы, устраняющие или компенсирующие социальное неравенство, вызванное болезнью или ограниченными возможностями) (Hansson 2003).

Дискуссии по проблеме принятия риска в целом можно найти в работах Macpherson 2008, Hansson 2013 и Oberdick 2014. Справедливость подвергания риску обсуждается в Ferretti 2010 и Heyward & Roser 2016. Проблемы прав и риска обсуждаются в Thomson 1986 и (с особым акцентом на ответственности) в Kermisch 2012 и van de Poel et al. 2012.

Теория принятия решений

Теория принятия решений связана с поиском лучшего способа достижения максимально выигрышного исхода с учетом имеющихся параметров.

Теория принятия решений исходит из факта наличия у нас ценностей и целей, и в ходе анализа просчитывается лучший способ их достижения.

Принятие решения в условиях риска и неопределенности — это одна из ключевых тем в теории принятия решений. Обычно считается, что если нами установлены (например, посредством моральной философии) ценностные параметры набора потенциальных результатов, тогда для определения наилучшего способа действовать в условиях риска или неопределенности для достижения наилучшего результата будет достаточно и чисто инструментального анализа. (Критическое размышление об этом допущении см. в Hansson 2013: 49–51.)

Ценности, взятые за исходные в теории принятия решений, могут (хотя и необязательно) быть моральными ценностями таких типов, которые разрабатывает и изучает моральная философия.

Теория принятия решений традиционно отдает предпочтение утилитаризму, чья структура подходит для большинства формальных моделей принятия решений. Стандартный подход теории принятия решений к риску состоит в максимизации ожидаемой полезности, что может считаться мягким продолжением утилитаризма действия.

Однако ожидаемая максимизация полезности может подвергаться сомнению. Весьма интересные варианты были представлены в рамках альтернативных правил решений.

В качестве обоснования таких шагов высказываются два основных соображения.

Во-первых, приводятся примеры, в свете которых вряд ли возможно утверждать, что ожидаемая максимизация полезности является единственным нормативно обоснованным правилом решений (Allais 1953, Ellsberg 1961).

Во-вторых, ряд психологических экспериментов показывает, что принятие решений человеком, как правило, значительно отклоняется от максимизации ожидаемой полезности.

Первый способ обоснования ставит под вопрос нормативную устойчивость ожидаемой полезности, тогда как второй выявляет ее недостатки в качестве описательной модели.

При альтернативном наборе вариантов при выборе решений вероятности, используемые при расчетах ожидаемой полезности, заменяет другой набор параметров («вес принятия решения», decision weights). Данный подход был предложен в 1961 Уильямом Феллнером (Fellner 1961).

В большинстве этих построений все вероятности преобразуются некой функцией преобразования r.

Вместо максимизации стандартной ожидаемой полезности

p(x)⋅u(x)

агент максимизирует

r(p(x))⋅u(x)

Было предложено несколько правил решений с такой структурой.

Одним из первых был Ханда (Handa 1977). В настоящее время наиболее известна в данной традиции теория перспектив (Kahneman and Tversky 1979), которая была разработана с целью описать наблюдения в ходе психологических экспериментов по принятию решений и оказалась точнее теории ожидаемой полезности.

Теория перспектив — это довольно сложная концепция, которая содержит также и другие отклонения от теории ожидаемой полезности. Традиционный акцент на результатах заменяется акцентом на потерях и приобретениях, которые трактуются асимметрически.

Проблема с функцией r, как описано выше, состоит в том, что преобразованные вероятности, которые она производит, не дают в сумме 1 за исключением тривиального случая, когда r является функцией тождественности (Fishburn 1978).

Для решения проблемы Куиггин (Quiggin 1982) представил правило максимизации ожидаемой полезности (также называемой полезностью с ранговыми вероятностями).

Вместо того, чтобы заменить p(x) функцией индивидуальной вероятности r(p(x)), он замещает ее функцией, которая также зависит от других вероятностей и полезностей, причастных к этой проблеме. Результаты распределяются от худшего к лучшему, что приводит к вектору результатов ⟨x1,x2,…,xn⟩, так что u(x1)≤u(x2)≤…≤u(xn).

Затем вес принятия решения может быть приписан каждому результату с учетом его вероятности и позиции в ранговой последовательности результатов.

Поскольку вес принятия решений может отличаться для результатов с одинаковой вероятностью, тривиализацию Фишберна здесь применять нельзя. Имеются свидетельства, которые указывают на то, что модели ранговой полезности могут быть эмпирически более точными, чем теория перспектив (Harrison and Ross 2017).

Были также предложены некоторые другие модели, где вероятности в ожидаемой максимизации полезности заменяются каким-либо другим типом веса принятия решений (Gilboa and Schmeidler 1994, Buchak 2014).

Риск в экономическом анализе

Риск играет центральную роль в экономической деятельности. При капитализме в странах с рыночной экономикой предприниматель неизбежно должен принимать на себя экономические риски. Решения, касающиеся инвестиций, и функционирование финансовых рынков можно осмыслить только с учетом рисков. Таким образом, нет ничего удивительного в том, что современная экономическая теория с упором на математические модели экономической деятельности разработала несколько формальных моделей принятия рисков.

Измерение экономических рисков

Портфельный анализ, который был разработан в 1950-х Гарри Марковицем (Markowitz 1952), Джеймсом Тобином (Tobin 1958) и другими исследователями, стал важным шагом в продвижении экономического анализа риска.

Исследователи применили простую статистическую характеристику, а именно стандартное отклонение (или колебание, выраженное квадратом стандартного отклонения) в качестве меры рискованности.

Следовательно, при сравнении двух вариантов инвестирования тот вариант, чей экономический результат обладает крупнейшим стандартным отклонением, считается наиболее рискованным. В сравнении двух альтернатив каждая из них может быть выражена двумя числами — параметром ожидания и стандартным отклонением, или рискованностью.

Инвесторы обычно предпочитают инвестиции с максимально возможным уровнем ожиданий и наименьшей степенью риска.

Однако инвесторы отличаются тем, какой относительный вес они приписывают ожиданиям в связи с избежанием риска. Учитывая вес принятия решений, можно определить оптимальный индивидуальный портфель.

С конца 1960-х годов разрабатывались альтернативные показатели риска.

Возможно, наиболее важным из них стал показатель, предложенный Майклом Ротшильдом и Джозефом Стиглицем (Rothschild and Stiglitz 1970).

Если мы переместим вероятностную меру с центральной позиции в конец вероятностного распределения, оставив при этом ее среднее значение без изменения, мы повысим риск, связанный с данным распределением. На основе этого принципа (сохранения среднего значения) может быть создан параметр с более привлекательными математическими свойствами по сравнению с предлагаемыми стандартными параметрами отклонения.

Параметры подходов к риску

Мы отличаемся друг от друга тем, как мы относимся к риску.

Некоторые из нас охотно идут на риск, который для других кажется излишним. Понятие гарантированных эквивалентных исходов или результатов можно использовать для прояснения таких отличий.

Примем X за рискованный результат. Другой результат Y является гарантированным эквивалентным результатом X, если и только если (1) Y не имеет неопределенности и (2) X и Y рассматриваются агентом как равнозначно приемлемые.

Например, пусть X — это лотерейный билет с 50 % шансом выиграть что-либо, для которого вы назначаете 10 ютилов (единиц полезности), и 50 % шансом не выиграть ничего.

Ожидаемая полезность этого билета составляет 5 ютилов. Теперь предположим, что вас устраивает как гарантированное получение 3 ютилов, так и получение X. Тогда ваш подход состоит в стремлении уйти от риска.

Общим критерием стремления уйти от риска (предотвращение риска, осторожность) является формула CE(X)<EU(X). Аналогично, вы безразличны к риску в отношении X, если CE(X)=EU(X), и вы стремитесь рисковать (положительное отношение к риску, любовь рисковать), если EU(X)<CE(X).

В экономике избегание риска обычно относится к деньгам. Пусть X представляет лотерейный билет с 50 % шансом выиграть € 100. Предположим, что вы оцениваете билет в € 30. Тогда мы имеем EU(X)=u(100)/2 и CE(X)=u(30). Это значит, что u(30)=u(100)/2. Если это устойчивая модель, тогда полезность денег, как показано на диаграмме с суммой денег x на оси x и их полезностью u(x) на оси y, будет выражаться в виде вогнутой кривой.

Аналогично, рискованное поведение будет выражено выпуклостью кривой. В том случае, если функция полезности u последовательно дифференцируема дважды, это можно выразить более точно с использованием меры Эрроу — Пратта (меры приятия/неприятия риска), согласно которой избегание риска агентом в любой точке x равно −u′′(x)/u′(x).

Таким образом, человек с функцией полезности u1 чаще стремится избегать риска в точке x, чем человек с функцией полезности u2, если и только если

−u1′′(x)/u1′(x)>−u2′′(x)/u2′(x)

(Arrow 1965, Pratt 1964).

Мера Эрроу — Пратта имеет преимущество в виде постоянства при изменениях функции полезности, что сохраняет отношение предпочтения, которое она представляет (то есть она постоянна независимо от умножения полезности на положительную постоянную и прибавления произвольной постоянной).

С другой стороны, то, что подход к риску может быть адекватно представлен колебаниями полезности денег, с философской точки зрения может быть поставлено под вопрос. Можно утверждать, что осторожность и полезность денег — это две разные проблемы и они должны иметь независимые представления.

Экспериментальная экономика

Исследования в области экспериментальной экономики свидетельствуют о том, что фактические агенты зачастую не соответствуют теоретическому критерию рациональности. Одна из наиболее популярных описательных теорий, пытающихся зафиксировать реальное поведение в условиях риска, — это теория перспектив, разработанная Даниелом Канеманом и Амосом Тверски приблизительно в 1980 году (Tversky & Kahneman 1986).

В ней различаются две стадии процесса принятия решения. Во время первой стадии (редактирование) просчитываются прибыли и убытки различных вариантов. Они соотносятся с определенной начальной точкой, которой обычно является расположение текущего актива.

В ходе второй стадии (оценка) варианты оцениваются способом, схожим с анализом ожидаемой полезности, но полезности и вероятности заменяются другими аналогичными параметрами. Полезность заменяется параметром асимметричности прибылей и убытков. Объективные вероятности преобразуются функцией, придающей большее значение разности вероятностей ближе к концам, а не к центру распределения. Таким образом, она сильнее снижает вероятность негативного результата с 2 % до 1 %, а не с 51 % до 50 %.

Теория перспектив может объяснить некоторые случаи, при которых реальное поведение отличается от теоретических моделей рационального поведения в условиях риска.

Таким образом, превышение нагрузки вероятностных изменений ближе к нулю или единице может использоваться для объяснения того, почему люди покупают страховку или лотерейные билеты. Однако теория перспектив не подходит в качестве нормативной теории для рационального поведения в условиях риска. Возможно, нормативная и описательная теории риска должны идти разными путями.

Анализ риска и выгоды

Анализ соотношения риска и выгоды (RBA), или анализ затраты/выгоды (CBA), — это набор техник принятия решения, которые оценивают преимущества и недостатки в количественном выражении.

В типичном анализе риска и выгоды многомерные проблемы сводятся к одной плоскости. Это достигается за счет приписывания денежной ценности каждому потенциальному результату. Обычно неясные результаты оцениваются в соответствии с моделью ожидаемой полезности. Это значит, что отрицательная ценность риска достигается путем умножения вероятности нежелательного события на денежную ценность, выражающую ее интенсивность (Sen 2000; Sunstein 2005).

Большинство философских дискуссий по поводу анализа риска и выгоды сосредоточены на вопросе назначения цены потери человеческой жизни в денежном выражении (MacLean 1994, Heinzerling 2000, 2002).

Утверждается, что жизни и деньги несопоставимы, а определение и использование подобных «цен жизни» (live values) является неуважением к человеческой жизни.

Защитники анализа риска и выгоды в ответ заявляли, что эти ценности представляют собой формальные конструкции, выражающие то, сколько общество готово заплатить (или вынуждено заплатить), чтобы спасти человеческую жизнь. Анализ риска и выгоды может помочь принимающим решение лицам спасти как можно больше жизней, учитывая, что у них ограниченное количество ресурсов, которые они могут направить на реализацию спасительной политики (Sunstein 2005).

Множество присваиваемых значений, используемых в анализе затраты/выгоды, основаны на оценках или параметрах (гипотетического) желания платить.

Такие оценки в большей степени влияют на богатых людей, поскольку они могут заплатить больше других, сохраняя свои интересы. Данный метод можно скорректировать, добавив модель выгоды к заявленной готовности платить. Однако существуют определенные проблемы, связанные с реализацией и интерпретацией исследований желания платить (Grüne-Yanoff 2009).

Анализ риска и выгоды поднимает и другие фундаментальные проблемы, вызывающие значительный интерес у ряда философов (Hansson 2007). В силу своего количественного характера такой анализ игнорирует проблемы, которые трудно измерить, такие как риски культурного обеднения, социальной изоляции и растущего напряжения между слоями общества.

Вместе с тем, с учетом его собирательной структуры, анализ риска и выгоды зачастую оставляет без внимания социальную справедливость и прочие распределительные аспекты, хотя на самом деле они поддаются исчислению.

Библиография

• Нозик, Р., 2008, Анархия, государство и утопия, Москва: ИРИСЭН.

• Ролз, Дж., 2010, Теория справедливости, Москва: Издательство ЛКИ.

• Allais, M., 1953, “Le comportement de l’homme rationnel devant le risque: critique des postulats et axiomes de l’école Américaine”, Econometrica, 21: 503–546.

• Allhoff, F., 2009, “Risk, Precaution, and Emerging Technologies”, Studies in Ethics, Law, and Technology, 3(2), published online 25 June, 2009. doi:10.2202/1941-6008.1078

• Arrow, K.J., 1965, Aspects of the Theory of Risk-Bearing. Yrjö Jahnsson Lectures. Helsinki: Yrjö Jahnssonin Säätiö.

• Boholm, M. et al., 2016, “The Concepts of Risk, Safety, and Security: Applications in Everyday Language.”, Risk Analysis, 36 (2): 320–338.

• Buchak, L., 2014, Risk and Rationality, Oxford: Oxford University Press.

• Caney, S., 2009, “Climate Change and the Future: Discounting for Time, Wealth, and Risk”, Journal of Social Philosophy, 40(2): 163–186.

• Cranor C., 1997, “The Normative Nature of Risk Assessment: Features and Possibilities”, Risk: Health, Safety & Environment, 8: 123–36.

• –––, 2005. “The Science Veil Over Tort Law Policy: How Should Scientific Evidence Be Utilized in Toxic Tort Law?”, Law and Philosophy, 24(2): 139–210.

• –––, 2016, Toxic Torts: Science, Law and the Possibility of Justice (second edition), Cambridge: Cambridge University Press.

• –––, 2017, Tragic Failures: How and Why We Are Harmed by Toxic Chemicals, Oxford: Oxford University Press, 2017.

• Doorn, N., and S.O. Hansson, 2015, “Design for the value of safety”, in J. van den Hoven, I. van de Poel, and P. Vermaas (eds), Handbook of Ethics, Values and Technological Design, Dordrecht: Springer, 491–511.

• Ellsberg, D., 1961, “Risk, Ambiguity, and the Savage Axioms”, Quarterly Journal of Economics, 75: 643–669.

• Fellner, W. 1961, “Distortion of subjective probabilities as a reaction to uncertainty”, Quarterly Journal of Economics, 75: 670–689.

• Ferretti, M.P., 2010, “Risk and Distributive Justice: The Case of Regulating New Technologies”, Science and Engineering Ethics, 16(3): 501–515.

• Fishburn, P.C., 1978, “On Handa’s ‘New theory of cardinal utility’ and the maximization of expected return”, Journal of Political Economy, 86: 321–324.

• Gigerenzer, G., 2002, Calculated Risks: How to Know When Numbers Deceive You, New York: Simon and Schuster.

• Gilboa, I. and D. Schmeidler, 1994, “Additive representations of non-additive measures and the Choquet integral”, Annals of Operations Research, 52: 43–65.

• Goodwin, W., 2009, “How Does the Theologizing of Physics Contribute to Global Warming?”, Environmental Philosophy, 6(2): 21–42.

• Gordijn, B., 2005, “Nanoethics: From Utopian Dreams and Apocalyptic Nightmares Towards a More Balanced View”, Science and Engineering Ethics, 11(4): 521–533.

• Grüne-Yanoff, T., 2009, “Mismeasuring the Value of Statistical Life”, Journal of Economic Methodology, 16 (2): 109–123.

• Handa, J., 1977, “Risk, probabilities, and a new theory of cardinal utility”, Journal of Political Economy, 85: 97–122.

• Hansson, S. O., 2003, “Ethical criteria of risk acceptance”, Erkenntnis, 59: 291–309.

• –––, 2004, “Weighing Risks and Benefits”, Topoi, 23: 145–152.

• –––, 2006, “Economic (ir)rationality in risk analysis”, Economics and Philosophy, 22: 231–241.

• –––, 2007, “Philosophical Problems in Cost-Benefit Analysis”, Economics and Philosophy 23: 163–183.

• –––, 2013, The Ethics of Risk: Ethical analysis in an uncertain world, New York: Palgrave MacMillan.

• Harrison, G.W. and D. Ross, 2017, “The empirical adequacy of cumulative prospect theory and its implications for normative assessment”, Journal of Economic Methodology, 24: 150–165.

• Harsanyi, J.C., 1953, “Cardinal utility in welfare economics and in the theory of risk-taking”, Journal of Political Economy, 61: 434–435.

• Harsanyi, J.C., 1955, “Cardinal welfare, individualistic ethics, and interpersonal comparisons of utility”, Journal of Political Economy, 63: 309–321.

• Harsanyi, J.C., 1975, “Can the maximin principle serve as a basis for morality? A critique of John Rawls’s theory”, American Political Science Review, 69: 594–606.

• Heinzerling, L., 2000, “The rights of statistical people.”, Harvard Environmental Law Review 24: 189–207.

• –––, 2002, “Markets for arsenic”, Georgetown Law Journal, 90: 2311–2339.

• Hempel, C.G., 1965, Aspects of scientific explanation, and other essays in the philosophy of science, New York: Free Press.

• Heyward, C., and D. Roser (eds.), 2016, Climate Justice in a Non-Ideal World, Oxford: Oxford University Press.

• Intemann, K., 2015, “Distinguishing Between Legitimate and Illegitimate Values in Climate Modeling.”, European Journal for Philosophy of Science, 5(2): 217–232.

• Jellinek, S. D., 1981, “On The Inevitability Of Being Wrong”, Annals of the New York Academy of Science, 363: 43–47.

• John, S., 2017, “From Social Values to P-Values: The Social Epistemology of the Intergovernmental Panel on Climate Change”, Journal of Applied Philosophy, 34 (2): 157–171.

• Kahneman, D. and A. Tversky 1979, “Prospect theory: An analysis of decision under risk”, Econometrica, 47: 263–293.

• Kermisch, C., 2012, “Risk and Responsibility: A Complex and Evolving Relationship”, Science and Engineering Ethics, 18(1): 91–102.

• Lemons, J., et al., 1997, “The Precautionary Principle: Scientific Uncertainty and Type I and Type II Errors”, Foundations of Science, 2(2): 207–236.

• MacLean, D. (ed.), 1986, Values at Risk (Maryland Studies in Public Philosophy), Totowa, NJ: Rowman and Littlefield.

• –––, 1994, “Cost-benefit analysis and procedural values”, Analyse & Kritik, 16(2): 166–180.

• Machina, M.D. and M. Rothschild, 1987, “Risk”, in J. Eatwell, M. Milgate, and P. Newman (eds.), The New Palgrave: A Dictionary of Economic Theory and Doctrine (Volume 4), London and New York: Macmillan and Stockton, pp. 201–205.

• Macpherson, J.A.E., 2008, “Safety, Risk Acceptability, and Morality”, Science and Engineering Ethics, 14(3): 377–390.

• McKerlie, D., 1986, “Rights and Risk”, Canadian Journal of Philosophy, 16: 239–52.

• Markowitz, H.M., 1952, “Portfolio Selection”, Journal of Finance, 7(1): 77–91.

• McKinney, W.J., 1996, “Prediction and Rolston’s Environmental Ethics: Lessons From the Philosophy of Science”, Science and Engineering Ethics, 2(4): 429–440.

• Möller, N. and S.O. Hansson, 2008, “Principles of engineering safety: risk and uncertainty reduction”, Reliability Engineering and System Safety, 93: 776–783.

• Ng, Y.-K., 2005, “Intergenerational Impartiality: Replacing Discounting by Probability Weighting”, Journal of Agricultural and Environmental Ethics, 18(3): 237–257.

• Oberdiek, J., 2014, Imposing Risk: A Normative Framework, Oxford: Oxford University Press.

• Pratt, J. W., 1964, “Risk Aversion in the Small and in the Large”, Econometrica, 32: 122–136.

• Pritchard, D., 2015, “Risk”, Metaphilosophy, 46(3): 436–461.

• Prothero, D., 2013, “The Holocaust Denier’s Playbook and the Tobacco Smokescreen: Common Threads in the Thinking and Tactics of Denialists and Pseudoscientists”, pp. 341–358 in M. Pigliucci and M. Boudry (eds), Philosophy of Pseudoscience. Reconsidering the demarcation problem, Chicago: University of Chicago Press.

• Quiggin, J., 1982, “A theory of anticipated utility”, Journal of Economic Behavior & Organization, 3: 323–343.

• Rasmussen, Norman, et al., 1975, “Reactory Safety Study”, WASH-1400, Washington, DC: US NRC.

• Rawls, J., 1957, “Justice as Fairness”, Journal of Philosophy, 54: 653–662.

• –––, 1974, “Some Reasons for the Maximin Criterion”, American Economic Review, 64: 141–146.

• Rechard, R.P., 1999, “Historical relationship between performance assessment for radioactive waste disposal and other types of risk assessment”, Risk Analysis, 19(5): 763–807.

• Rothschild, M. and J. Stiglitz, 1970, “Increasing risk: 1. A definition”, Journal of Economic Theory, 2: 225–243.

• Scanlon, T.M., 1982, “Contractualism and Utilitarianism,” in A. Sen and B. Williams, Utilitarianism and Beyond, Cambridge: Cambridge University Press.

• Schelling T.C., 1996, “Research By Accident”, Technological Forecasting And Social Change, 53: 15–20.

• Sen, A., 2000, “The discipline of cost-benefit analysis”, Journal of Legal Studies, 29: 931–952.

• Shrader-Frechette, K., 1991, Risk and Rationality. Philosophical Foundations for Populist Reforms, Berkeley: University of California Press.

• –––, 1997, “Hydrogeology and Framing Questions Having Policy Consequences”, Philosophy of Science (Supplement), 64: S149-S160.

• –––, 2005, “Flawed Attacks on Contemporary Human Rights: Laudan, Sunstein, and the Cost-Benefit State”, Human Rights Review, 7(1): 92–110.

• –––, 2005, Environmental Justice: Creating Equality, Reclaiming Democracy, New York: Oxford University Press.

• Sjöberg, L., 2004, “The Methodology of Risk Perception Research”, Quality and Quantity, 34: 407–418.

• Sunstein, C.R., 2005, “Cost-Benefit Analysis and the Environment”, Ethics, 115: 351–385.

• Thompson, P. B., 1985, “Risking or Being Willing: Hamlet and the DC-10”, Journal of Value Inquiry, 19: 301–310.

• Thomson, J.J., 1985, “Imposing Risks”, in To Breathe Freely, Mary Gibson (ed.), Totowa, NJ: Rowman and Allanheld, 124–140.

• –––, 1986, Rights, Restitution and Risk: Essays in Moral Philosophy, Cambridge, Mass.: Harvard University Press.

• Tobin, J., 1958, “Liquidity preference as behavior towards risk”, Review of Economic Studies 25(2): 65–86.

• Tversky, A. and D. Kahneman, 1986, “Rational Choice and the Framing of Decisions”, Journal of Business, 59: 251–278.

• van den Belt, H. and B. Gremmen., 2002, “Between Precautionary Principle and ‘Sound Science’: Distributing the Burdens of Proof.”, Journal of Agricultural and Environmental Ethics, 15(1): 103–122.

• van de Poel, I., et al., 2012, “The Problem of Many Hands: Climate Change as an Example”, Science and Engineering Ethics, 18(1): 49–67.

• Wagner, W. E., 1995, “The Science Charade In Toxic Risk Regulation”, Columbia Law Review, 95: 1613–1723.

• Weinberg, A. M., 1972, “Science and Trans-Science”, Minerva, 10: 209–222.

• Wetmore, J.M., 2008, “Engineering with Uncertainty: Monitoring Air Bag Performance”, Science and Engineering Ethics, 14(2): 201–218.

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)